- Введение

- Возможности решателя scipy.optimize.root для численного решения систем алгебраических нелинейных уравнений

- Методы решения систем нелинейных уравнений

- Выбор модельной функции

- Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью библиотечной функции optimize.root для разных методов отыскания корней

- Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью программы написанной на Python 3 с учётом соотношений (1)-(8) для отыскания корней по модифицированному методу Ньютона

- Итерационные методы решения системы линейных алгебраических уравнений

- Общие сведения об итерационных методах или методе простой итерации

- Метод Якоби

- Метод Зейделя

- Метод простой итерации

- VMath

- Инструменты сайта

- Основное

- Навигация

- Информация

- Действия

- Содержание

- Матрица Якоби и якобиан

- Определение и основные свойства

- Функциональная зависимость

- Якобиан как коэффициент растяжения

- Неявная функция

- Геометрические приложения

- Решение системы нелинейных уравнений

- 📺 Видео

Введение

Многие прикладные задачи приводят к необходимости нахождения общего решения системы нелинейных уравнений. Общего аналитического решения системы нелинейных уравнений не найдено. Существуют лишь численные методы.

Следует отметить интересный факт о том, что любая система уравнений над действительными числами может быть представлена одним равносильным уравнением, если взять все уравнения в форме

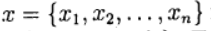

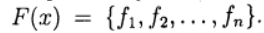

Для численного решения применяются итерационные методы последовательных приближений (простой итерации) и метод Ньютона в различных модификациях. Итерационные процессы естественным образом обобщаются на случай системы нелинейных уравнений вида:

Обозначим через

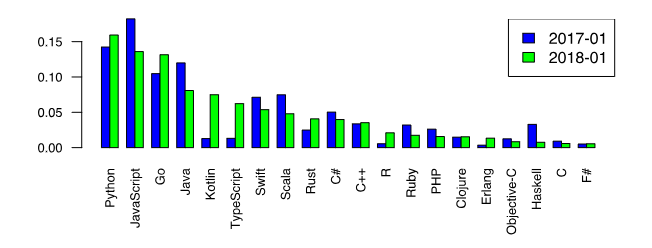

Теперь вернёмся к всеми любимому Python и отметим его первенство среди языков программирования, которые хотят изучать [1].

Этот факт является дополнительным стимулом рассмотрения числительных методов именно на Python. Однако, среди любителей Python бытует мнение, что специальные библиотечные функции, такие как scipy.optimize.root, spsolve_trianular, newton_krylov, являются самым лучшим выбором для решения задач численными методами.

С этим трудно не согласится хотя бы потому, что в том числе и разнообразие модулей подняло Python на вершину популярности. Однако, существуют случаи, когда даже при поверхностном рассмотрении использование прямых известных методов без применения специальных функций библиотеки SciPy тоже дают неплохие результаты. Иными словами, новое- это хорошо забытое старое.

Так, в публикации [2], на основании проведенных вычислительных экспериментов, доказано, что библиотечная функция newton_krylov, предназначенная для решения больших систем нелинейных уравнений, имеет в два раза меньшее быстродействие, чем алгоритм TSLS+WD

(two-step least squares), реализованный средствами библиотеки NumPy.

Целью настоящей публикации является сравнение по числу итераций, быстродействию, а главное, по результату решения модельной задачи в виде системы из ста нелинейных алгебраических уравнений при помощи библиотечной функции scipy.optimize.root и методом Ньютона, реализованного средствами библиотеки NumPy.

Возможности решателя scipy.optimize.root для численного решения систем алгебраических нелинейных уравнений

Библиотечная функция scipy.optimize.root выбрана в качестве базы сравнения, потому что имеет обширную библиотеку методов, пригодных для сравнительного анализа.

scipy.optimize.root(fun, x0, args=(), method=’hybr’, jac=None, tol=None,callback=None, ptions=None)

fun — Векторная функция для поиска корня.

x0 –Начальные условия поиска корней

method:

hybr -используется модификация Пауэлл гибридный метод;

lm – решает системы нелинейных уравнений методом наименьших квадратов.

Как следует из документации [3] методы broyden1, broyden2, anderson, linearmixing, diagbroyden, excitingmixing, krylov являются точными методами Ньютона. Остальные параметры являются «не обязательными» и с ними можно ознакомится в документации.

Методы решения систем нелинейных уравнений

Приведенный далее материал действительно можно прочитать в литературе, например в [4], но я уважаю своего читателя и для его удобства приведу вывод метода по возможности в сокращенном виде. Те, кто не любит формулы, этот раздел пропускают.

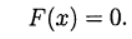

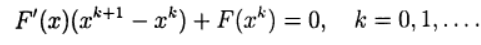

В методе Ньютона новое приближение для решения системы уравнений (2) определяется из решения системы линейных уравнений:

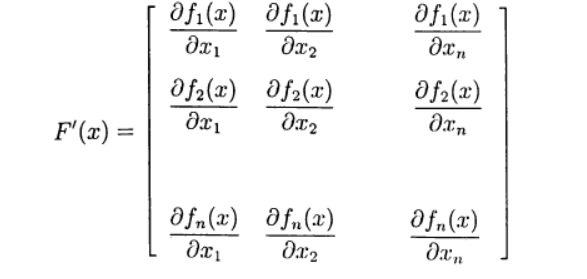

Определим матрицу Якоби:

Запишем(3) в виде:

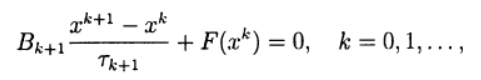

Многие одношаговые методы для приближенного решения (2) по аналогии с двухслойными итерационными методами для решения систем линейных алгебраических уравнений можно записать в виде:

где

При использовании записи (6) метод Ньютона (5) соответствует выбору:

Система линейных уравнений (5) для нахождения нового приближения

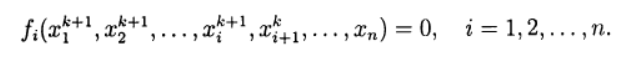

При решении систем нелинейных уравнений можно использовать прямые аналоги стандартных итерационных методов, которые применяются для решения систем линейных уравнений. Нелинейный метод Зейделя применительно к решению (2) дает:

В этом случае каждую компоненту нового приближения из решения нелинейного уравнения, можно получить на основе метода простой итерации и метода Ньютона в различных модификациях. Тем самым снова приходим к двухступенчатому итерационному методу, в котором внешние итерации проводятся в соответствии с методом Зейделя, а внутренние — с методом Ньютона.

Основные вычислительные сложности применения метода Ньютона для приближенного решения систем нелинейных уравнений связаны с необходимостью решения линейной системы уравнений с матрицей Якоби на каждой итерации, причем от итерации к итерации эта матрица меняется. В модифицированном методе Ньютона матрица Якоби обращается только один раз:

Выбор модельной функции

Такой выбор не является простой задачей, поскольку при увеличении числа уравнений в системе в соответствии с ростом числа переменных результат решения не должен меняться, поскольку в противном случае невозможно отследить правильность решения системы уравнений при сравнении двух методов. Привожу следующее решение для модельной функции:

Функция f создаёт систему из n нелинейных уравнений, решение которой не зависит от числа уравнений и для каждой из n переменных равно единице.

Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью библиотечной функции optimize.root для разных методов отыскания корней

Только один из методов, приведенных в документации [3] прошёл тестирование по результату решения модельной функции, это метод ‘krylov’.

Решение для n=100:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1.]

Krylov method iteration = 4219

Optimize root time 7.239 seconds:

Вывод: С увеличением числа уравнений вдвое заметно появление ошибок в решении. При дальнейшем увеличении n решение становится не приемлемым, что возможно из-за автоматической адаптации к шагу, эта же причина резкого падения быстродействия. Но это только моё предположение.

Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью программы написанной на Python 3 с учётом соотношений (1)-(8) для отыскания корней по модифицированному методу Ньютона

Решение для n=100:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1.]

Newton iteration = 13

Newton method time 0.496 seconds

Решение для n=200:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1.]

Newton iteration = 14

Newton method time 1.869 seconds

Чтобы убедиться в том, что программа действительно решает систему, перепишем модельную функцию для ухода от корня со значением 1 в виде:

Получим:

Solution:

[ 0.96472166 0.87777036 0.48175823 -0.26190496 -0.63693762 0.49232062

-1.31649896 0.6865098 0.89609091 0.98509235]

Newton iteration = 16

Newton method time 0.046 seconds

Вывод: Программа работает и при изменении модельной функции.

Теперь вернёмся к начальной модельной функции и проверим более широкий диапазон для n, например в 2 и 500.

n=2

Solution:

[1. 1.]

Newton iteration = 6

Newton method time 0.048 seconds

n=500

Видео:2.2 Итерационные методы решения СЛАУ (Якоби, Зейделя, релаксации)Скачать

Итерационные методы решения системы линейных алгебраических уравнений

В данной статье мы расскажем общие сведения об итерационных методах решения СЛАУ, познакомим с методом Зейделя и Якоби, а также приведем примеры решения систем линейных уравнений при помощи данных методов.

Видео:Метод простой итерации Пример РешенияСкачать

Общие сведения об итерационных методах или методе простой итерации

Метод итерации — это численный и приближенный метод решения СЛАУ.

Суть: нахождение по приближённому значению величины следующего приближения, которое является более точным. Метод позволяет получить значения корней системы с заданной точностью в виде предела последовательности некоторых векторов (итерационный процесс). Характер сходимости и сам факт сходимости метода зависит от выбора начального приближения корня x 0 .

Рассмотрим систему A x = b .

Чтобы применить итерационный метод, необходимо привести систему к эквивалентному виду x = B x + d . Затем выбираем начальное приближение к решению СЛАУ x ( 0 ) = ( x 1 0 , x 2 0 , . . . x m 0 ) и находим последовательность приближений к корню.

Для сходимости итерационного процесса является достаточным заданное условие В 1 . Окончание итерации зависит от того, какой итерационный метод применили.

Видео:Метод простых итераций пример решения нелинейных уравненийСкачать

Метод Якоби

Метод Якоби — один из наиболее простых методов приведения системы матрицы к виду, удобному для итерации: из 1-го уравнения матрицы выражаем неизвестное x 1 , из 2-го выражаем неизвестное x 2 и т.д.

Результатом служит матрица В , в которой на главной диагонали находятся нулевые элементы, а все остальные вычисляются по формуле:

b i j = — a i j / a i i , i , j = 1 , 2 . . . , n

Элементы (компоненты) вектора d вычисляются по следующей формуле:

d i = b i / a i i , i = 1 , 2 , . . . , n

Расчетная формула метода простой итерации:

x ( n + 1 ) = B x ( x ) + d

Матричная запись (координатная):

x i ( n + 1 ) = b i 1 x n 1 + b i 2 x ( n ) 2 + . . . + b

Критерий окончания в методе Якоби:

x ( n + 1 ) — x ( n ) ε 1 , где ε 1 = 1 — B B ε

В случае если B 1 / 2 , то можно применить более простой критерий окончания итераций:

x ( n + 1 ) — x ( n ) ε

Решить СЛАУ методом Якоби:

10 x 1 + x 2 — x 3 = 11 x 1 + 10 x 2 — x 3 = 10 — x 1 + x 2 + 10 x 3 = 10

Необходимо решить систему с показателем точности ε = 10 — 3 .

Приводим СЛАУ к удобному виду для итерации:

x 1 = — 0 , 1 x 2 + 0 , 1 x 3 + 1 , 1 x 2 = — 0 , 1 x 1 + 0 , 1 x 3 + 1 x 3 = 0 , 1 x 1 — 0 , 1 x 2 + 1

Выбираем начальное приближение, например: x ( 0 ) = 1 , 1 1 1 — вектор правой части.

В таком случае, первая итерация имеет следующий внешний вид:

x 1 ( 1 ) = — 0 , 1 × 1 + 0 , 1 × 1 + 1 , 1 = 1 , 1 x 2 ( 1 ) = — 0 , 1 × 1 , 1 + 0 , 1 + 1 = 0 , 99 x 3 ( 1 ) = 0 , 1 × 1 , 1 — 0 , 1 × 1 + 1 = 1 , 01

Аналогичным способом вычисляются приближения к решению:

x ( 2 ) = 1 , 102 0 , 991 1 , 011 , x ( 3 ) = 1 , 102 0 , 9909 1 , 0111 , x ( 4 ) = 1 , 10202 0 , 99091 1 , 01111

Находим норму матрицы В , для этого используем норму B ∞ .

Поскольку сумма модулей элементов в каждой строке равна 0,2, то B ∞ = 0 , 2 1 / 2 , поэтому можно вычислить критерий окончания итерации:

x ( n + 1 ) — x ( n ) ε

Далее вычисляем нормы разности векторов:

x ( 3 ) — x ( 2 ) ∞ = 0 , 002 , x ( 4 ) — x ( 3 ) ∞ = 0 , 00002 .

Поскольку x ( 4 ) — x ( 3 ) ∞ ε , то можно считать, что мы достигли заданной точности на 4-ой итерации.

x 1 = 1 , 102 ; x 2 = 0 , 991 ; x 3 = 1 ,01 1 .

Видео:Метод Зейделя Пример РешенияСкачать

Метод Зейделя

Метод Зейделя — метод является модификацией метода Якоби.

Суть: при вычислении очередного ( n + 1 ) — г о приближения к неизвестному x i при i > 1 используют уже найденные ( n + 1 ) — е приближения к неизвестным x 1 , x 2 , . . . , x i — 1 , а не n — о е приближение, как в методе Якоби.

x i ( n + 1 ) = b i 1 x 1 ( n + 1 ) + b i 2 x 2 ( n + 1 ) + . . . + b i , i — 1 x i — 2 ( n + 1 ) + b i , i + 1 x i + 1 ( n ) +

+ . . . + b i m x m ( n ) + d i

За условия сходимости и критерий окончания итераций можно принять такие же значения, как и в методе Якоби.

Решить СЛАУ методом Зейделя. Пусть матрица системы уравнений А — симметричная и положительно определенная. Следовательно, если выбрать начальное приближение, метод Зейделя сойдется. Дополнительных условий на малость нормы некоторой матрицы не накладывается.

Решим 3 системы уравнений:

2 x 1 + x 2 = 3 x 1 — 2 x 2 = 1 , x 1 + 2 x 2 = 3 2 x 1 — x 2 = 1 , 2 x 1 — 0 , 5 x 2 = 3 2 x 1 + 0 , 5 x 2 = 1

Приведем системы к удобному для итерации виду:

x 1 ( n + 1 ) = — 0 , 5 x 2 ( n ) + 1 , 5 x 2 ( n + 1 ) = 0 , 5 x 1 ( n + 1 ) + 0 , 5 , x 1 ( n + 1 ) = — 2 x 2 ( n ) + 3 x 2 ( n + 1 ) = 2 x 1 ( n + 1 ) — 1 , 2 x 1 — 0 , 5 x 2 = 3 2 x 1 + 0 , 5 x 2 = 1 .

Отличительная особенность, условие сходимости выполнено только для первой системы:

Вычисляем 3 первых приближения к каждому решению:

1-ая система: x ( 0 ) = 1 , 5 — 0 , 5 , x ( 1 ) = 1 , 75 0 , 375 , x ( 2 ) = 1 , 3125 0 , 1563 , x ( 3 ) = 1 , 4219 0 , 2109

Решение: x 1 = 1 , 4 , x 2 = 0 , 2 . Итерационный процесс сходится.

2-ая система: x ( 0 ) = 3 — 1 , x ( 1 ) = 5 9 , x ( 2 ) = — 15 — 31 , x ( 3 ) = 65 129

Итерационный процесс разошелся.

Решение: x 1 = 1 , x 2 = 2

3-я система: x ( 0 ) = 1 , 5 2 , x ( 1 ) = 2 — 6 , x ( 2 ) = 0 2 , x ( 3 ) = 0 2

Итерационный процесс зациклился.

Решение: x 1 = 1 , x 1 = 2

Видео:После этого видео, ТЫ РЕШИШЬ ЛЮБУЮ Систему Нелинейных УравненийСкачать

Метод простой итерации

Если А — симметричная и положительно определенная, то СЛАУ приводят к эквивалентному виду:

x = x — τ ( A x — b ) , τ — итерационный параметр.

Расчетная формула имеет следующий внешний вид:

x ( n + 1 ) = x ( n ) — τ ( A x n — b ) .

Здесь B = E — τ A и параметр τ > 0 выбирают таким образом, чтобы по возможности сделать максимальной величину B 2 .

Пусть λ m i n и λ m a x — максимальные и минимальные собственные значения матрицы А .

τ = 2 / ( λ m i n + λ m a x ) — оптимальный выбор параметра. В этом случае B 2 принимает минимальное значение, которое равняется ( λ m i n + λ m a x ) / ( λ m i n — λ m a x ) .

Видео:Способы решения систем нелинейных уравнений. 9 класс.Скачать

VMath

Инструменты сайта

Основное

Навигация

Информация

Действия

Содержание

Вспомогательная страница к разделам ОПРЕДЕЛИТЕЛЬ и ЛИНЕЙНЫЕ ОТОБРАЖЕНИЯ

Видео:Метод Ньютона (метод касательных) Пример РешенияСкачать

Матрица Якоби и якобиан

Видео:4.2 Решение систем нелинейных уравнений. МетодыСкачать

Определение и основные свойства

Матрицей Якоби системы из $ m_ $ функций $ <f_1(x_1,dots,x_n),dots,f_m(x_,dots,x_n)> $ по переменным $ x_,dots,x_n $ называется матрица, составленная из всевозможных частных производных: $$ mathbf J = left[ frac right]_ = left( begin / & / & dots & / \ / & / & dots & / \ dots & && dots \ / & / & dots & / end right) , . $$ В частном случае $ m_=1 $ матрица Якоби состоит из одной строки: этот вектор в $ mathbb R_^ $ или $ mathbb C^ $ называется градиентом функции $ f_ $ (в точке $ (x_1,dots,x_) $): $$ operatorname (f) = left( frac,dots, frac right) . $$

Можно сказать, что в общем случае системы функций их матрица Якоби состоит из строк, являющихся градиентами этих функций.

Пример. Для системы линейных функций

$$f_1=a_x_1+dots+a_x_n — b_1,dots, f_m=a_x_1+dots+a_x_n — b_m $$ матрица Якоби будет матрицей коэффициентов при переменных: $$ mathbf J = left(begin a_ & a_ & dots & a_ \ dots & && dots \ a_ & a_ & dots & a_ end right) . $$

В частном случае $ m=n_ $ матрица Якоби становится квадратной и тогда ее определитель называется якобианом или определителем Якоби или функциональным определителем системы из $ n_ $ функций $ <f_1(x_1,dots,x_n),dots,f_(x_1,dots,x_n)> $ по переменным $ x_,dots,x_n $: $$ (x_1,dots,x_n)=frac= $$ $$ =left| begin / & / & dots & / \ / & / & dots & / \ dots & && dots \ / & / & dots & / end right|= det left[ frac right]_^n . $$ В этом же случае след матрицы Якоби называется дивергенцией вектора $ (f_1,f_2,dots,f_n) $: $$ operatorname

Пример. Якобиан системы двух функций $ $ равен

Теорема [Якоби]. Если $ A_,dots,A_ $ — алгебраические дополнения элементов $ j_ $-й строки якобиана, то

Видео:Матричный метод решения систем уравненийСкачать

Функциональная зависимость

Следующая теорема и ее следствия являются прямыми обобщениями соответствующих результатов из линейной алгебры.

Теорема. Якобиан системы функций $ < f_,f_2,dots,f_n > $ тождественно равен нулю в некоторой области $ mathbb_ $:

$$ frac equiv 0 mbox mbox mbox X in mathbb $$ тогда и только тогда, когда между этими функциями имеется функциональная зависимость в $ mathbb $, т.е. существует функция $ G(y_1,y_2,dots,y_n) notequiv 0 $ такая, что $$ G(f_1(X),f_2(X),dots,f_n(X))equiv 0 mbox mbox mbox X in mathbb . $$

Приведем соображения, показывающие необходимость обращения якобиана в нуль для существования функциональной зависимости в системе функций $ $. Дополнительно предположим, что у функции $ G $ существуют частные производные по ее аргументам. Продифференцируем тождество $ G(f_1(X),f_2(X),dots,f_n(X))equiv 0 $ по $ x_1,dots,x_n $. Получим систему тождеств $$ left<begin frac frac+ & frac frac+ &dots + frac frac & equiv 0, \ dots & & & dots \ frac frac+ & frac frac+ &dots + frac frac & equiv 0; end right. $$ здесь после вычисления производных $ $ следует произвести подстановку $ y_1=f_1(X),dots,y_n=f_n(X) $. Получившуюся систему можно рассматривать как линейную однородную относительно этих последних выражений. Хотя бы одна из них не должна быть тождественно нулевой (в противном случае функция $ G $ не содержала бы ни одной функции $ f_j $). Но тогда для совместности системы необходимо, чтобы ее определитель был равен нулю. Этот определитель, с точностью до транспонирования, совпадает с якобианом.

Пример. Являются ли полиномы

$$ f_1=x_1+x_2+x_3-1,quad f_2=x_1x_2+x_1x_3+x_2x_3-2,quad f_3=x_1^2+x_2^2+x_3^2+3 $$ функционально зависимыми?

Решение. $$ frac= $$ $$ = left| begin 1 & 1 & 1 \ x_2+x_3 & x_1+x_3 & x_1+x_2 \ 2x_1 & 2x_2 & 2x_3 end right| = 2 left| begin 1 & 1 & 1 \ x_2+x_3 & x_1+x_3 & x_1+x_2 \ x_1 & x_2 & x_3 end right|= $$ $$ = left| begin 1 & 1 & 1 \ x_1+x_2+x_3 & x_1+x_2+x_3 & x_1+x_2+x_3 \ x_1 & x_2 & x_3 end right|equiv 0 $$ (мы воспользовались здесь свойствами 4 и 5 определителя, выписанными ☞ ЗДЕСЬ ). Ответ оказывается положительным: рассматриваемые полиномы являются функционально зависимыми. В данном примере эта зависимость сравнительно просто «отлавливается» наметанным взглядом: $$(f_1+1)^2-2(f_2+2)-(f_3-3) equiv 0 . $$ ♦

Если какие-то $ mathfrak r $ функций системы $ < f_, dots, f_n > $ связаны в $ mathbb $ функциональным соотношением

$$ H(f_, dots, f_<j_>) equiv 0 , $$ то любой минор порядка $ mathfrak r $ якобиана, выбранный из соответствующих строк, будет тождественно равен нулю в $ mathbb_ $.

Пусть $ mathfrak r_ $ обозначает ранг матрицы Якоби системы функций $ <f_1,dots,f_> $ по переменным $ x_,dots,x_n $. Если минор этой матрицы

$$ frac<D(f_1,dots,f_)> $$ отличен от нуля в $ mathbb_ $, то функции $ f_1,dots,f_ $ функционально независимы в $ mathbb $, а все оставшиеся функции системы (при условии $ mathfrak r непрерывная функция $ varphi (y) $ такая, что $$ f(varphi(y)) equiv y, varphi(y_0)=x_0 , . $$ В этой окрестности функция $ varphi $ является непрерывно дифференцируемой и выполняется равенство $$ varphi^ (y) = frac <f^(x)> $$ для значений $ x $ и $ y $, связанных равенством $ y=f(x) $.

Конструктивных аналитических способов нахождения функции, обратной к заданной $ y=f(x) $ можно сказать, что и нет. Задача сводится к разрешению этого уравнения относительно $ x $. Однако уже для полиномиальных $ f(x) $ решение такого уравнения в «хороших» функциях, т.е. в радикалах, возможно, в общем случае, только для $ deg f ♦

В альтернативу интерполяции, можно поставить задачу об аппроксимации обратной функции с помощью степенных рядов. Составим формальный ряд $$ varphi(y)=B_0+B_1(y-y_0) + B_2(y-y_0)^2+ dots + B_k(y-y_0)^k+ dots $$ Для значения $ y_0 $ из теоремы получаем два коэффициента этого ряда $$ B_0=x_0, B_1= 1/f^ (x_0) , . $$ Как получить следующий коэффициент $ B_2 $? Заметим, что если бы у обратной функции существовала бы вторая производная, то $ B_2 $ был бы следующим коэффициентом ряда Тейлора: $$ B_2 = varphi^(y_0)/2 , . $$ Для получения выражения $ varphi^(y_0) $ продифференцируем по $ y $ тождество $ f(varphi(y)) equiv y $. Тождество останется справедливым $$ f^_x(varphi(y)) varphi^_y(y)equiv 1 , . $$ При подстановке сюда $ y=y_0 $ получаем уже известное нам равенство $ f^_x(x_0)varphi^_y(y_0)=1 $. Но если продифференцировать еще раз, то получим $$ f^_(varphi(y)) left(varphi^_y(y)right)^2+f^_x(varphi(y)) varphi^_(y)equiv 0 , . $$ При подстановке сюда $ y=y_0 $ получаем $$ varphi^_(y_0)=- frac<f^_(x_0)><[f^_x(x_0)]^3> $$ в дополнительном предположении, что вторая производная от $ f(x) $ существует. Вычисление остальных старших производных $ varphi(y) $ в точке $ y_0 $ производится аналогичным приемом — лишь бы только существовали эти производные для функции $ f(x) $. $$ varphi^_(y_0)= frac<3,[f^_(x_0)]^2- f^_x(x_0)f^_(x_0) ><[f^_x(x_0)]^5> , $$ $$ varphi^_(y_0)= $$ А для выведения общей формулы $ varphi^_(y_0) $ используется формула Фаа-ди-Бруно. При полиномиальной $ f(x) $ ряд Тейлора для обратной функции всегда может быть построен.

Пример. Для функции $ y=-x^3+3,x-1 $ приведенного выше примера первые $ 8 $ членов разложение обратной функции в ряд Тейлора в точке $ y_0=-1 $ имеют вид

$$ widehat(y)= frac(y+1)+frac(y+1)^3+frac(y+1)^5 +frac(y+1)^7 , . $$ На графике внизу кривая $ y = widehat(x)$ изображена цветом охры.

И только близко к точке $ x=1 $ заметно расхождение с $ y= varphi(x) $. ♦

Теорема утверждает, что обратная функция будет определена в окрестности точки $ y_0 $, удовлетворяющей условию. Насколько большой можно сделать эту окрестность? Ограничимся случаем полиномиальных $ f(x) $. При движении от точки $ y_0 $ вправо или влево по числовой оси значения $ varphi^(y) $ меняются непрерывным образом и стремятся к бесконечности только когда соответствующие значения $ x $ стремятся к корням полинома $ f^(x) $. Если этот полином имеет вещественные корни, и $ mu_1 непрерывные функции $ varphi(u,v) $ и $ psi(u,v) $ такие, что $$ f(varphi(u,v),psi(u,v)) equiv u, g(varphi(u,v),psi(u,v)) equiv v, varphi(u_0,v_0)=x_0, psi(u_0,v_0)=x_0 , . $$ Функции $ varphi $ и $ psi $ непрерывно дифференцируемы в этой окрестности, и для их матрицы Якоби выполняется равенство $$ left(begin partial varphi/ partial u & partial varphi/ partial v \ partial psi/ partial u & partial psi/ partial v end right)= left(begin partial f/ partial x & partial f/ partial y \ partial g/ partial x & partial g/ partial y end right)^ , . $$ Левая часть этого матричного равенства вычисляется в точках $ (u,v) $, соответствующих точкам $(x,y) $, в которых вычисляется правая часть (т.е. эти пары подчиняются равенствам $ u=f(x,y),v=g(x,y) $).

Отображение окрестности точки $ (u_0,v_0) $ в окрестность точки $ (x_0,y_0) $, заданное векторной функцией $ (varphi(u,v), psi(u,v)) $ из теоремы, называется обратным отображением к отображению $ (f(x,y),g(x,y)) $.

При выполнении условий теоремы, в соответствующих друг другу точках $ (u,v) $ и $ (x,y) $ выполняется равенство

Пример. Отображение

$$ (e^x cos y, e^x sin y > $$ отображает $ (x,y) $-плоскость $ mathbb R^2 $ во множество $ mathbb R^2 setminus (0,0) $ на плоскости $ (u,v) $. Якобиан $$ frac equiv e^ $$ отличен от нуля во всей плоскости $ (x,y) $. Можно было бы ожидать, что обратное отображение однозначно определено во всей области $ mathbb R^2 setminus (0,0) $. Но очевидно, что это не так: бесконечное множество $$ $$ отображается в точку $ (u,v)=(1,0) $. Обратное отображение бесконечнозначно. Результат теоремы справедлив если мы рассмотрим отображение любой полосы шириной $ 2 pi $ плоскости $(x,y) $, параллельной оси $ O x $. Например, полосы $ 0le y ♦

Мы в дальнейшем ограничимся случаем полиномиальных функций. Для этого случая хотя бы можно ожидать, что якобиан будет из того же класса, что и сами функции, т.е. полиномом. Ну и можно что-то конструктивное сказать о представлении обратных отображений — хотя они уже, как правило, не будут полиномиальными, но задачу их представления можно свести к одномерному случаю.

Пример. Найти обратное отображение к отображению

Решение. Якобиан $$ frac=left| begin -4,x+5,y-2 & 5,x-6,y+1 \ 2,x-2,y-1 & -2,x+2,y+1 end right|=-2,x^2+4,xy-2,y^2+3,x -3,y-1equiv $$ $$ equiv (-2x+2y+1)(x-y-1) , . $$ отличен от нуля во всех точках плоскости, за исключением лежащих на прямых $ y=x-1 $ и $ y=x-1/2 $. Согласно теореме, обратное отображение должно существовать, например, в окрестности точки $ (u,v)=(-5,7)=(f(-1,1),g(-1,1)) $.

Для разрешения системы алгебраических уравнений $ u=f(x,y), v=g(x,y) $ относительно $ x $ и $ y $ применим теорию исключения. Результант системы по переменной $ y $ $$ mathcal X(x)=(1-v)x^2+(u+11,v-9)x+u^2-6,u-34,v+9,v^2+6,uv+21 $$ оказывается квадратным полиномом 1) по $ x $. Корни уравнения $ mathcal X(x) =0$ следующие: $$ frac<u+11v-9pm (u+3v-1)sqrt> , . $$ Из них только соответствующий знаку минус в числителе, т.е. $$ varphi(u,v):=frac<u+11v-9 — (u+3v-1)sqrt> $$ удовлетворяет условию $ varphi(-5,7)=-1 $. Аналогично находим выражение для $ y $: $$ psi(u,v):=frac<u+10v-8 — (u+2v)sqrt> , . $$ Области определения обеих функций одинаковы: $$ , . $$ Теперь проверим справедливость формулы, связывающей якобианы. Имеем (в окрестности точки $ (-5,7) $) $$ frac= frac<2(1-v)sqrt>left[sqrt-1 right] , . $$ Подстановка сюда $ u=f(x,y), v= g(x,y) $ дает (в окрестности точки $ (1,-1) $) $$ frac equiv left( frac right)^ , . $$ ♦

Сформулируем обобщение предыдущего результата в $ mathbb R^n $.

Теорема. Если якобиан системы полиномов

$$ subset mathbb R[X] $$ отличен от нуля в некоторой точке $ X_0 in mathbb R^n $, то существует окрестность этой точки, в которой система уравнений $$ y_1=f_1(x_1,dots,x_n),dots,y_n=f_n(x_1,dots,x_n) , $$ рассматриваемая относительно переменных $ x_,dots,x_n $, имеет единственное решение, лежащее в окрестности точки $$ Y_0=(f_1(X_0), dots , f_n(X_0)) , . $$ Иными словами: существует и однохначно определяется система непрерывных в окрестности точки $ Y_0 $ функций $$ , $$ таких, что $$ f_1(varphi_1(Y),dots, varphi_n(Y))equiv y_1,dots, f_n(varphi_1(Y),dots, varphi_n(Y))equiv y_n $$ и $$ (varphi_1(Y_0),dots, varphi_n(Y_0))=X_0 , .$$ Функции $ _^n $ непрерывно дифференцируемы в указанной окрестности. Матрицы Якоби систем функций $ _^n$ и $ _^n$ связаны равенством: $$ left( begin / & / & dots & / \ dots & && dots \ / & / & dots & / end right)= left( begin / & / & dots & / \ dots & && dots \ / & / & dots & / end right)^ , . $$ Здесь производные в левых и правых частях равенства вычислены в соответствующих точках.

При выполнении условий теоремы, в соответствующих друг другу точках $ Y $ и $ X $ выполняется равенство

Видео:Способы решения систем нелинейных уравнений. Практическая часть. 9 класс.Скачать

Якобиан как коэффициент растяжения

Еще одну важную сущность якобиана сформулируем в решении следующего примера.

Пример. Отображение

$$ left< begin u=f(x,y):=&-1/2,x^2-3/4,xy-y^2-x-1/2,y+2,\ v=g(x,y):=& 1/4,x^2-1/2,xy-1/2,y^2-x+1/2,y+1 end right. $$ отображает окрестность точки $ (x_0,y_0)=(0,1) $ в окрестность точки $ (u_0,v_0)=(1/2,1) $. Квадрат $ 0 le x le 1, 0 le y le 1$ отображается в область плоскости $ (u,v) $, органиченную параметрически заданными кривыми $$ , , $$ $$ , . $$

Решение. Для ответа на вопрос надо обладать возможностью вычислить точную площадь области, закрашенной оранжевым на рисунке. Я не уверен, что это можно сделать сведением к случаю «табличных» интегралов, но, по крайней мере, численными методами можно найти приближение этой площади. Попробуем получить такое приближение, заменив границу области — криволинейную — на параллелограмм. С этой целью проведем в точке $ (u_0,v_0) $ касательные к ограничивающую область кривым: $$ < (u,v)= (u_0+ f^_x(x_0,y_0) t, v_0+ g^_x(x_0,y_0) t) mid t in mathbb R > mbox < (u,v)=(u_0+ f^_y(x_0,y_0) tau, v_0+ g^_y(x_0,y_0) tau )mid tau in mathbb R > , . $$

Эта аппроксимация, в нашем конкретном случае, очевидно неудачная. Как следствие, площадь получишегося параллелограмма визуально отличается от искомой площади.

Видео:10 Численные методы решения нелинейных уравненийСкачать

Неявная функция

Обобщением рассмотренного в предыдущем пункте случая, т.е. выражения вектора $ X=(x_1,dots,x_n) $ через вектор $ Y=(y_1,dots,y_n) $ при задании многомерного отображения формулами $$ Y= (f_1(X),dots,f_n(X)) $$ является случай неявной функции.

В линейном случае, эта задача встречается при записи общего решения системы линейных уравнений. Если эта система представлена в виде $$ left< begin a_y_1 &+a_y_2&+ ldots&+a_y_n &+a_x_&+ldots & +a_x_ -b_1=0,\ a_y_1 &+a_y_2&+ ldots&+a_y_n &+a_x_&+ldots & +a_x_ -b_2=0,\ dots & & & & dots & dots & & dots \ a_y_1 &+a_y_2&+ ldots&+a_y_n &+a_x_&+ldots & +a_x_ -b_n=0 end right. $$ при $ mge 1 $, то при условии $$ left| begin a_ & a_ & dots & a_ \ a_ & a_ & dots & a_ \ dots &&& dots \ a_ & a_ & dots & a_ end right| ne 0 $$ ее можно разрешить относительно переменных $ y_1,dots,y_n $ — например, по формулам Крамера или посредством обратной матрицы: $$ left( begin y_ \ y_ \ vdots \ y_ end right) = — left( begin a_ & a_ & dots & a_ \ a_ & a_ & dots & a_ \ dots &&& dots \ a_ & a_ & dots & a_ end right)^ left( begin a_ & dots & a_ \ a_ & dots & a_ \ dots && dots \ a_ & dots & a_ end right) left( begin x_ \ \ vdots \ x_ end right)+left( begin a_ & a_ & dots & a_ \ a_ & a_ & dots & a_ \ dots &&& dots \ a_ & a_ & dots & a_ end right)^ left( begin b_ \ \ vdots \ b_ end right) , . $$

В случае нелинейного уравнения $$ f(x,y)=0 , $$ критерий существования неявной функции дается следующей теоремой

Теорема 1 [о неявной функции]. Пусть функция $ f $ — непрерывно дифференцируема в окрестности точки $ (x_0,y_0) $ и

$$ f(x_0,y_0)=0 , partial f /partial y mid_ne 0 , .$$ Тогда существует окрестность точки $ x_0 $, в которой уравнение $ f(x,y)=0 $ имеет единственное вещественное решение относительно $ y $, лежащее в окрестности $ y_0 $. Иными словами: существует вещественная непрерывная функция $ varphi(x) $, такая, что $$ varphi(x_0)=y_0, f(x,varphi(x)) equiv 0 $$ (последнее тождество выполняется в заявленной окрестности $ x_0 $). При этом $ varphi(x) $ является непрерывно дифференцируемой функцией в той же окрестности и выполняется тождество $$ varphi^(x)equiv-frac Bigg|_<_> , . $$

Нахождение явного выражения для $ y=varphi(x) $ является задачей еще более сложной, чем задача предыдущего пункта о нахождении обратной функции. Усложнение проявляется уже в проблеме поиска хотя бы одной точки $ (x_0,y_0) in mathbb R^2 $, удовлетворяющей уравнению $ f(x,y)=0 $. Проблема существования вещественного решения этого уравнения даже для случая полиномиальной функции $ f $ нетривиальна: см. пункт ☞ АЛГЕБРАИЧЕСКИЕ УРАВНЕНИЯ. Если вещественное решение удастся обнаружить, то нахождение неявной функции можно осуществить построением ряда Тейлора (или, в общем случае, при нарушении условия теоремы, в виде ряда Пюизё), сходящегося в некоторой окрестности точки $ x_0 $.

Результат теоремы $ 1 $ очевидным образом обобщается на случай неявной функции нескольких переменных: уравнение $$ f(x_1,dots,x_n, y) = 0 quad mbox n ge 2 $$ пытаются разрешить относительно $ y $.

Более общую задачу решения системы уравнений относительно нескольких переменных мы рассмотрим в частном случае уравнений алгебраических.

Теорема 2. Пусть имеется система полиномов

$$ subset mathbb R[X,Y], m ge 2 $$ от векторов переменных $ X=(x_1,dots,x_n) $ и $ Y=(y_1,dots,y_m) $. Пусть выполнены следующие условия:

$$ f_1(X_0,Y_0)=0, dots , f_m(X_0,Y_0)=0 , . $$

Рассмотрим сначала самый простой случай: $$ f(x,y,z)=0, g(x,y,z)=0 , . $$ Будем предполагать, что каждое из уравнений задает некоторую поверхность в $ mathbb R^3 $. Две неявно заданные алгебраические поверхности в $ mathbb R^3 $ могут не иметь вещественных точек пересечения. Как установить существование точек пересечения, т.е. наличие вещественных решений системы уравнений? Для полиномимальных $ f $ и $ g $ этот факт можно установить алгебраическими методами, которые проиллюстрирую на примере.

Пример. Пусть заданы две квадрики

$$ f(x,y,z):=frac9+frac-frac-1=0, $$ $$ g(x,y,z):= 111376, x^2-14656, xy+72128, xz+45184, y^2-45184, yz+76096, z^2+ $$ $$ +92136, x-118608, y+205104, z-1913751=0 $$ Первая является однополостным гиперболоидом, а вторая — эллипсоидом. Эти поверхности пересекаются по двум замкнутым кривым $ mathbf K_1 $ и $ mathbf K_2 $. На одной из них выбираем произвольную точку, например $$ (x_0,y_o,z_0) approx (1.959148, 3.864766, 3) , . $$

Отложив на несколько последующих абзацев ответ на вопрос, как эти координаты найдены, займемся задачей нахождения касательной к кривой $ mathbf K_1 $ в указанной точке.

Докажем, что в окрестности точки кривую $ mathbf K_1 $ можно представить параметрически $$ x=varphi_1 (z), y= varphi_2 (z), z= z , . $$ Действительно, матрица Якоби $$ mathbf J=left(begin 2/9 x & 1/6 y \ 222752, x-14656, y+72128, z + 92136 & -14656, x+90368, y-45184, z-118608 end right) $$ имеет ненулевой определитель в точке $ (x_0,y_o,z_0) $. В соответствии с теоремой 2, параметрическое представление кривой существует в некоторой окрестности точки $ z_0 $. Явное выражение для функций $ varphi_1, varphi_2 $ — отдельная нетривиальная проблема, но для поставленной конкретной задачи поиска касательной решение этой проблемы не требуется. Действительно, теорема 2 дает представление $$ (varphi_1^(z_0), varphi_2^(z_0),1) approx (-1.052314,1.445142,1) $$ для направляющего вектора касательной в виде явного выражения через значения функций $ f $ и $ g $ (и их производных) в точке $ (x_0,y_0,z_0) $.

А теперь проверим полученный результат альтернативным алгоритмом, задействовав технологию исключения переменных (которую мы уже использовали в предыдущем ПУНКТЕ). Cоставив результант полиномов $ f $ и $ g $ по переменной $ y $, придем к уравнению $$ F(x,z)=0 $$ при $$ F(x,z):=mathcal R_y(f,g)= $$ $$ =fracx^4+fracx^3z+fracx^2z^2+frac,xz^3+fracz^4+ $$ $$ +frac x^3+frac x^2 z+frac x z^2+frac z^3- $$ $$ -fracx^2-fracxz-fracz^2-fracx-fracz+frac , . $$ Имеем: $ deg_x F=4 $, т.е. уравнение $ F(x,z)=0 $ разрешимо в радикалах относительно $ x $. По крайней мере, теоретически, функцию $ varphi_1(z) $ можно представить в виде конечной комбинации элементарных функций и корней второй и третьей степеней от коэффициентов полинома. Реальное же представление для $ varphi_1(z) $ крайне громоздко и, с точки зрения практического использования, неконструктивно.

Уравнение четвертой степени может иметь от нуля до четырех вещественных корней в зависимости от значений $ z $. При подстановке конкретного значения $z =z_0 in mathbb R $ получаем полином $ F(x,z_0) $ от одной переменной $ x $. Мы можем однозначно и чисто алгебраическим алгоритмом установить число его вещественных корней. Так, $$ F(x,3)equiv fracx^4+126573205 x^3+fracx^2+fracx-frac $$ имеет два вещественных корня $ approx -3.309237 $ и $ approx 1.959148 $. Второй из них мы и взяли выше в качестве $ x_0 $. Таким образом, для $ varphi_1(z) $ мы получили представление в виде неявной функции $ F(x,z)=0 $ при заданном значении $ varphi_1(z_0)=x_0 $. Но тогда для этой функции должна работать теорема 1, которая дает представление $$ varphi_1^(z_0)= -frac Bigg|_<_> , . $$ Результат совпадает с полученным выше.

Понятно, что для получения $ varphi_2(z) $ мы должны произвести процедуру исключения переменной $ x $ из системы $ f=0,g=0 $, т.е. вычислить результант $ G(y,z):=mathcal R_x(f,g) $. Далее найти корень полинома $ G(y,z_0) $ (выбрав тот из них, что соответствует уже найденном у значению $ x_0 $) и т.д. Убеждаемся, что $$ varphi_2^(z_0)= -frac Bigg|_<_> , . $$

Вопроc: какая же связь между матрицей Якоби и результантами $ mathcal R_x(f,g), mathcal R_y(f,g) $ приводит — в результате применения двух различных алгоритмов — к совершенно разным представлениям для $ varphi_1^(z_0), varphi_2^(z_0) $, имеющим, тем не менее, одинаковые значения? ♦

Если система полиномов

$$ $$ удовлетворяет условиям теоремы в некоторой точке $ (X_0,Y_0) in mathbb R^ $, то существует окрестность точки $ X_0 $, в которой справедливо равенство $$ frac=(-1)^n frac bigg/ frac , . $$ Здесь производные вычислены в соответствующих точках.

Видео:Способы решения систем нелинейных уравнений. Практическая часть. 9 класс.Скачать

Геометрические приложения

Теорема. Пусть на плоскости заданы две кривые уравнениями

$$ f(x,y)=0 quad u quad g(x,y)=0 $$ и они пересекаются в точке $ (x_,y_0) $. Тогда величина угла $ gamma $, под которым происходит это пересечение вычисляется по формуле $$ operatorname (gamma) = pm frac<frac frac — frac frac><frac frac + fracfrac> $$ где все производные в правой части вычислены в точке $ (x_,y_0) $.

Утверждение следует из свойства градиента: вычисленный в точке кривой, он определяет направляющий вектор нормали к этой кривой.

Если $ (x_,y_0) $ — точка пересечения кривых $ f(x,y)=0 $ и $ g(x,y)=0 $, то

Показать, что если функции $ u_(x,y) $ и $ v_(x,y) $ связаны соотношениями Коши-Римана (Даламбера-Эйлера):

$$ frac equiv frac , frac equiv — frac $$ в некоторой области $ mathbb_ $, то в этой области их линии уровня, то есть кривые $ u(x,y) = c_1 $ и $ v(x,y) = c_2 $ при $ subset mathbb R $, могут пересекаться только под прямым углом.

Видео:8 Метод простой итерации Ручной счет Решение системы линейных уравнений СЛАУСкачать

Решение системы нелинейных уравнений

Рассмотрим систему двух вещественных алгебраических уравнений $$ f(x,y)=0, g(x,y)=0 , . $$ По аналогии с методом Ньютона решения уравнения от одной неизвестной, попробуем найти вещественное решение этой системы, сгенерировав итерационную последовательность в $ mathbb R^2 $, сходящуюся к этому решению. Допустим, что из каких-то соображений нам удалось установить, что вещественное решение системы существует, и что некоторая точка $ (x_0, y_0) $ достаточно близка к этому решению. Раскладываем полиномы по формуле Тейлора по степеням $ x-x_0, y-y_0 $ и оставляем в этих разложениях только первые слагаемые: $$ f(x,y)equiv f(x_0,y_0)+ fracBigg|_(x-x_0)+fracBigg|_(y-y_0) + dots , , $$ $$ g(x,y)equiv g(x_0,y_0)+ fracBigg|_(x-x_0)+fracBigg|_(y-y_0) + dots , . $$ Теперь вместо системы нелинейных уравнений рассматриваем систему $$ left< begin f(x_0,y_0)&+ fracBigg|_(x-x_0)+fracBigg|_(y-y_0) &= 0,\ g(x_0,y_0)&+ fracBigg|_(x-x_0)+fracBigg|_(y-y_0) &= 0 end right. $$ линейных уравнений. Она гарантировано имеет решение если матрица $$ mathbf J= left( begin partial f /partial x & partial f /partial y \ partial g /partial x & partial g /partial y end right) $$ будет неособенной при $ x=x_0,y=y_0 $. При этом предположении решение системы единственно и может быть выражено в виде $$ left( begin x_1 \ y_1 end right)= left( begin x_0 \ y_0 end right) — mathbf J^ left( begin f(x_0,y_0) \ g(x_0,y_0) end right) , . $$ Получаем полную аналогию с одномерным методом Ньютона; роль производной теперь выполняет матрица Якоби. Можно ожидать, что точка $ (x_1,y_1) $ будет лежать ближе к неизвестному нам решению исходной системы, нежели стартовая точка $ (x_0, y_0 ) $. Если это предположение выполняется, то можно попытаться организовать вычисление итерационной последовательности $$ left< left( begin x_j \ y_j end right)= left( begin x_ \ y_ end right) — mathbf J^ Bigg|_<_<(x_,y_)>> left( begin f(x_,y_) \ g(x_,y_) end right) right>_^ $$ и потестировать ее на сходимость к решению. Одно ограничение для этого умозаключения довольно очевидно: матрица Якоби должна быть невырожденной на всех итерациях (а, желательно, и не очень близкой к вырожденным матрицам).

Подробнее о методе Ньютона решения систем нелинейных уравнений ☞ ЗДЕСЬ.

📺 Видео

Методы численного анализа - Метод Ньютона, секущих для решения систем нелинейных уравненийСкачать

Решение систем линейных уравнений методом простой итерации в ExcelСкачать

Методы решения систем нелинейных уравнений. Метод Ньютона. Численные методы. Лекция 14Скачать

Решение нелинейного уравнения методом простых итераций (программа)Скачать

МЗЭ 2021 Лекция 11 Метод Ньютона для решения систем нелинейных уравненийСкачать

Вычислительная математика. Лекция 4. Решение нелинейных уравнений и систем уравненийСкачать

Численные методы. Вебинар. ( 24.12.21 ) Решение систем нелинейных уравнений.Скачать