Линейное уравнение регрессии имеет вид y=bx+a+ε

Здесь ε — случайная ошибка (отклонение, возмущение).

Причины существования случайной ошибки:

1. Невключение в регрессионную модель значимых объясняющих переменных;

2. Агрегирование переменных. Например, функция суммарного потребления – это попытка общего выражения совокупности решений отдельных индивидов о расходах. Это лишь аппроксимация отдельных соотношений, которые имеют разные параметры.

3. Неправильное описание структуры модели;

4. Неправильная функциональная спецификация;

5. Ошибки измерения.

Так как отклонения εi для каждого конкретного наблюдения i – случайны и их значения в выборке неизвестны, то:

1) по наблюдениям xi и yi можно получить только оценки параметров α и β

2) Оценками параметров α и β регрессионной модели являются соответственно величины а и b, которые носят случайный характер, т.к. соответствуют случайной выборке;

Тогда оценочное уравнение регрессии (построенное по выборочным данным) будет иметь вид y = bx + a + ε, где ei – наблюдаемые значения (оценки) ошибок εi, а и b соответственно оценки параметров α и β регрессионной модели, которые следует найти.

Для оценки параметров α и β — используют МНК (метод наименьших квадратов).

Система нормальных уравнений.

Для наших данных система уравнений имеет вид:

10a + 356b = 49

356a + 2135b = 9485

Из первого уравнения выражаем а и подставим во второе уравнение

Получаем b = 68.16, a = 11.17

Уравнение регрессии:

y = 68.16 x — 11.17

1. Параметры уравнения регрессии.

Выборочные средние.

1.1. Коэффициент корреляции

Рассчитываем показатель тесноты связи. Таким показателем является выборочный линейный коэффициент корреляции, который рассчитывается по формуле:

Линейный коэффициент корреляции принимает значения от –1 до +1.

Связи между признаками могут быть слабыми и сильными (тесными). Их критерии оцениваются по шкале Чеддока:

0.1 Y фактором X весьма высокая и прямая.

1.2. Уравнение регрессии (оценка уравнения регрессии).

Линейное уравнение регрессии имеет вид y = 68.16 x -11.17

Коэффициентам уравнения линейной регрессии можно придать экономический смысл. Коэффициент уравнения регрессии показывает, на сколько ед. изменится результат при изменении фактора на 1 ед.

Коэффициент b = 68.16 показывает среднее изменение результативного показателя (в единицах измерения у ) с повышением или понижением величины фактора х на единицу его измерения. В данном примере с увеличением на 1 единицу y повышается в среднем на 68.16.

Коэффициент a = -11.17 формально показывает прогнозируемый уровень у , но только в том случае, если х=0 находится близко с выборочными значениями.

Но если х=0 находится далеко от выборочных значений x , то буквальная интерпретация может привести к неверным результатам, и даже если линия регрессии довольно точно описывает значения наблюдаемой выборки, нет гарантий, что также будет при экстраполяции влево или вправо.

Подставив в уравнение регрессии соответствующие значения x , можно определить выровненные (предсказанные) значения результативного показателя y(x) для каждого наблюдения.

Связь между у и x определяет знак коэффициента регрессии b (если > 0 – прямая связь, иначе — обратная). В нашем примере связь прямая.

1.3. Коэффициент эластичности.

Коэффициенты регрессии (в примере b) нежелательно использовать для непосредственной оценки влияния факторов на результативный признак в том случае, если существует различие единиц измерения результативного показателя у и факторного признака х.

Для этих целей вычисляются коэффициенты эластичности и бета — коэффициенты. Коэффициент эластичности находится по формуле:

Он показывает, на сколько процентов в среднем изменяется результативный признак у при изменении факторного признака х на 1%. Он не учитывает степень колеблемости факторов.

В нашем примере коэффициент эластичности больше 1. Следовательно, при изменении Х на 1%, Y изменится более чем на 1%. Другими словами — Х существенно влияет на Y.

Бета – коэффициент показывает, на какую часть величины своего среднего квадратичного отклонения изменится в среднем значение результативного признака при изменении факторного признака на величину его среднеквадратического отклонения при фиксированном на постоянном уровне значении остальных независимых переменных:

Т.е. увеличение x на величину среднеквадратического отклонения этого показателя приведет к увеличению среднего Y на 0.9796 среднеквадратичного отклонения этого показателя.

1.4. Ошибка аппроксимации.

Оценим качество уравнения регрессии с помощью ошибки абсолютной аппроксимации.

Поскольку ошибка больше 15%, то данное уравнение не желательно использовать в качестве регрессии.

1.6. Коэффициент детерминации.

Квадрат (множественного) коэффициента корреляции называется коэффициентом детерминации, который показывает долю вариации результативного признака, объясненную вариацией факторного признака.

Чаще всего, давая интерпретацию коэффициента детерминации, его выражают в процентах.

R 2 = 0.98 2 = 0.9596, т.е. в 95.96 % случаев изменения x приводят к изменению у . Другими словами — точность подбора уравнения регрессии — высокая. Остальные 4.04 % изменения Y объясняются факторами, не учтенными в модели.

| x | y | x 2 | y 2 | x·y | y(x) | (yi— y ) 2 | (y-y(x)) 2 | (xi— x ) 2 | |y — yx|:y |

| 0.371 | 15.6 | 0.1376 | 243.36 | 5.79 | 14.11 | 780.89 | 2.21 | 0.1864 | 0.0953 |

| 0.399 | 19.9 | 0.1592 | 396.01 | 7.94 | 16.02 | 559.06 | 15.04 | 0.163 | 0.1949 |

| 0.502 | 22.7 | 0.252 | 515.29 | 11.4 | 23.04 | 434.49 | 0.1176 | 0.0905 | 0.0151 |

| 0.572 | 34.2 | 0.3272 | 1169.64 | 19.56 | 27.81 | 87.32 | 40.78 | 0.0533 | 0.1867 |

| 0.607 | 44.5 | .3684 | 1980.25 | 27.01 | 30.2 | 0.9131 | 204.49 | 0.0383 | 0.3214 |

| 0.655 | 26.8 | 0.429 | 718.24 | 17.55 | 33.47 | 280.38 | 44.51 | 0.0218 | 0.2489 |

| 0.763 | 35.7 | 0.5822 | 1274.49 | 27.24 | 40.83 | 61.54 | 26.35 | 0.0016 | 0.1438 |

| 0.873 | 30.6 | 0.7621 | 936.36 | 26.71 | 48.33 | 167.56 | 314.39 | 0.0049 | 0.5794 |

| 2.48 | 161.9 | 6.17 | 26211.61 | 402 | 158.07 | 14008.04 | 14.66 | 2.82 | 0.0236 |

| 7.23 | 391.9 | 9.18 | 33445.25 | 545.2 | 391.9 | 16380.18 | 662.54 | 3.38 | 1.81 |

2. Оценка параметров уравнения регрессии.

2.1. Значимость коэффициента корреляции.

По таблице Стьюдента с уровнем значимости α=0.05 и степенями свободы k=7 находим tкрит:

tкрит = (7;0.05) = 1.895

где m = 1 — количество объясняющих переменных.

Если tнабл > tкритич, то полученное значение коэффициента корреляции признается значимым (нулевая гипотеза, утверждающая равенство нулю коэффициента корреляции, отвергается).

Поскольку tнабл > tкрит, то отклоняем гипотезу о равенстве 0 коэффициента корреляции. Другими словами, коэффициент корреляции статистически — значим

В парной линейной регрессии t 2 r = t 2 b и тогда проверка гипотез о значимости коэффициентов регрессии и корреляции равносильна проверке гипотезы о существенности линейного уравнения регрессии.

2.3. Анализ точности определения оценок коэффициентов регрессии.

Несмещенной оценкой дисперсии возмущений является величина:

S 2 y = 94.6484 — необъясненная дисперсия (мера разброса зависимой переменной вокруг линии регрессии).

Sy = 9.7287 — стандартная ошибка оценки (стандартная ошибка регрессии).

S a — стандартное отклонение случайной величины a.

Sb — стандартное отклонение случайной величины b.

2.4. Доверительные интервалы для зависимой переменной.

Экономическое прогнозирование на основе построенной модели предполагает, что сохраняются ранее существовавшие взаимосвязи переменных и на период упреждения.

Для прогнозирования зависимой переменной результативного признака необходимо знать прогнозные значения всех входящих в модель факторов.

Прогнозные значения факторов подставляют в модель и получают точечные прогнозные оценки изучаемого показателя. (a + bxp ± ε) где

Рассчитаем границы интервала, в котором будет сосредоточено 95% возможных значений Y при неограниченно большом числе наблюдений и X p = 1 (-11.17 + 68.16*1 ± 6.4554)

(50.53;63.44)

С вероятностью 95% можно гарантировать, что значения Y при неограниченно большом числе наблюдений не выйдет за пределы найденных интервалов.

Индивидуальные доверительные интервалы для Y при данном значении X.

(a + bx i ± ε)

где

| xi | y = -11.17 + 68.16xi | εi | ymin | ymax |

| 0.371 | 14.11 | 19.91 | -5.8 | 34.02 |

| 0.399 | 16.02 | 19.85 | -3.83 | 35.87 |

| 0.502 | 23.04 | 19.67 | 3.38 | 42.71 |

| 0.572 | 27.81 | 19.57 | 8.24 | 47.38 |

| 0.607 | 30.2 | 19.53 | 10.67 | 49.73 |

| 0.655 | 33.47 | 19.49 | 13.98 | 52.96 |

| 0.763 | 40.83 | 19.44 | 21.4 | 60.27 |

| 0.873 | 48.33 | 19.45 | 28.88 | 67.78 |

| 2.48 | 158.07 | 25.72 | 132.36 | 183.79 |

С вероятностью 95% можно гарантировать, что значения Y при неограниченно большом числе наблюдений не выйдет за пределы найденных интервалов.

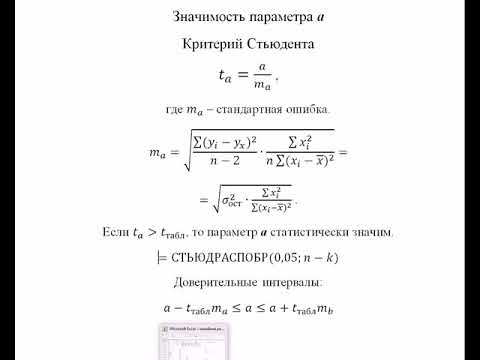

2.5. Проверка гипотез относительно коэффициентов линейного уравнения регрессии.

1) t-статистика. Критерий Стьюдента.

Проверим гипотезу H0 о равенстве отдельных коэффициентов регрессии нулю (при альтернативе H1 не равно) на уровне значимости α=0.05.

tкрит = (7;0.05) = 1.895

Поскольку 12.8866 > 1.895, то статистическая значимость коэффициента регрессии b подтверждается (отвергаем гипотезу о равенстве нулю этого коэффициента).

Поскольку 2.0914 > 1.895, то статистическая значимость коэффициента регрессии a подтверждается (отвергаем гипотезу о равенстве нулю этого коэффициента).

Доверительный интервал для коэффициентов уравнения регрессии.

Определим доверительные интервалы коэффициентов регрессии, которые с надежность 95% будут следующими:

(b — tкрит Sb; b + tкрит Sb)

(68.1618 — 1.895 • 5.2894; 68.1618 + 1.895 • 5.2894)

(58.1385;78.1852)

С вероятностью 95% можно утверждать, что значение данного параметра будут лежать в найденном интервале.

(a — ta)

(-11.1744 — 1.895 • 5.3429; -11.1744 + 1.895 • 5.3429)

(-21.2992;-1.0496)

С вероятностью 95% можно утверждать, что значение данного параметра будут лежать в найденном интервале.

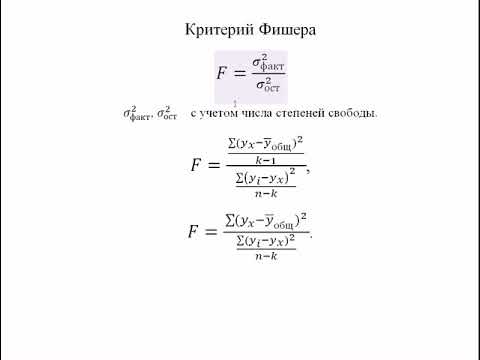

2) F-статистики. Критерий Фишера.

Проверка значимости модели регрессии проводится с использованием F-критерия Фишера, расчетное значение которого находится как отношение дисперсии исходного ряда наблюдений изучаемого показателя и несмещенной оценки дисперсии остаточной последовательности для данной модели.

Если расчетное значение с lang=EN-US>n-m-1) степенями свободы больше табличного при заданном уровне значимости, то модель считается значимой.

где m – число факторов в модели.

Оценка статистической значимости парной линейной регрессии производится по следующему алгоритму:

1. Выдвигается нулевая гипотеза о том, что уравнение в целом статистически незначимо: H0: R 2 =0 на уровне значимости α.

2. Далее определяют фактическое значение F-критерия:

где m=1 для парной регрессии.

3. Табличное значение определяется по таблицам распределения Фишера для заданного уровня значимости, принимая во внимание, что число степеней свободы для общей суммы квадратов (большей дисперсии) равно 1 и число степеней свободы остаточной суммы квадратов (меньшей дисперсии) при линейной регрессии равно n-2.

4. Если фактическое значение F-критерия меньше табличного, то говорят, что нет основания отклонять нулевую гипотезу.

В противном случае, нулевая гипотеза отклоняется и с вероятностью (1-α) принимается альтернативная гипотеза о статистической значимости уравнения в целом.

Табличное значение критерия со степенями свободы k1=1 и k2=7, Fkp = 5.59

Поскольку фактическое значение F > Fkp, то коэффициент детерминации статистически значим (Найденная оценка уравнения регрессии статистически надежна).

Проверка на наличие автокорреляции остатков.

Важной предпосылкой построения качественной регрессионной модели по МНК является независимость значений случайных отклонений от значений отклонений во всех других наблюдениях. Это гарантирует отсутствие коррелированности между любыми отклонениями и, в частности, между соседними отклонениями.

Автокорреляция (последовательная корреляция) определяется как корреляция между наблюдаемыми показателями, упорядоченными во времени (временные ряды) или в пространстве (перекрестные ряды). Автокорреляция остатков (отклонений) обычно встречается в регрессионном анализе при использовании данных временных рядов и очень редко при использовании перекрестных данных.

В экономических задачах значительно чаще встречается положительная автокорреляция, нежели отрицательная автокорреляция. В большинстве случаев положительная автокорреляция вызывается направленным постоянным воздействием некоторых неучтенных в модели факторов.

Отрицательная автокорреляция фактически означает, что за положительным отклонением следует отрицательное и наоборот. Такая ситуация может иметь место, если ту же зависимость между спросом на прохладительные напитки и доходами рассматривать по сезонным данным (зима-лето).

Среди основных причин, вызывающих автокорреляцию, можно выделить следующие:

1. Ошибки спецификации. Неучет в модели какой-либо важной объясняющей переменной либо неправильный выбор формы зависимости обычно приводят к системным отклонениям точек наблюдения от линии регрессии, что может обусловить автокорреляцию.

2. Инерция. Многие экономические показатели (инфляция, безработица, ВНП и т.д.) обладают определенной цикличностью, связанной с волнообразностью деловой активности. Поэтому изменение показателей происходит не мгновенно, а обладает определенной инертностью.

3. Эффект паутины. Во многих производственных и других сферах экономические показатели реагируют на изменение экономических условий с запаздыванием (временным лагом).

4. Сглаживание данных. Зачастую данные по некоторому продолжительному временному периоду получают усреднением данных по составляющим его интервалам. Это может привести к определенному сглаживанию колебаний, которые имелись внутри рассматриваемого периода, что в свою очередь может служить причиной автокорреляции.

Последствия автокорреляции схожи с последствиями гетероскедастичности: выводы по t- и F-статистикам, определяющие значимость коэффициента регрессии и коэффициента детерминации, возможно, будут неверными.

Обнаружение автокорреляции

1. Графический метод

Есть ряд вариантов графического определения автокорреляции. Один из них увязывает отклонения ei с моментами их получения i. При этом по оси абсцисс откладывают либо время получения статистических данных, либо порядковый номер наблюдения, а по оси ординат – отклонения ei (либо оценки отклонений).

Естественно предположить, что если имеется определенная связь между отклонениями, то автокорреляция имеет место. Отсутствие зависимости скоре всего будет свидетельствовать об отсутствии автокорреляции.

Автокорреляция становится более наглядной, если построить график зависимости ei от ei-1.

Видео:Парная регрессия: линейная зависимостьСкачать

Тема 11 Причинность, регрессия, корреляция

Причинность, регрессия, корреляция

Исследование объективно существующих связей между социально-экономическими явлениями и процессами является важнейшей задачей теории статистики. В процессе статистического исследования зависимостей вскрываются причинно-следственные отношения между явлениями, что позволяет выявлять факторы (признаки), оказывающие основное влияние на вариацию изучаемых явлений и процессов. Причинно-следственные отношения ‑ это такая связь явлений и процессов, когда изменение одного из них ‑ причины ведет к изменению другого ‑ следствия.

Финансово-экономические процессы представляют собой результат одновременного воздействия большого числа причин. Следовательно, при изучении этих процессов необходимо выявлять главные, основные причины, абстрагируясь от второстепенных.

В основе первого этапа статистического изучения связи лежит качественный анализ, связанный с анализом природы социального или экономического явления методами экономической теории, социологии, конкретной экономики.

Второй этап – построение модели связи, базируется на методах статистики: группировках, средних величинах, и так далее.

Третий, последний этап ‑ интерпретация результатов, вновь связан с качественными особенностями изучаемого явления. Статистика разработала множество методов изучения связей. Выбор метода изучения связи зависит от познавательной цели и задач исследования.

Признаки по их сущности и значению для изучения взаимосвязи делятся на два класса.

Признаки, обуславливающие изменения других, связанных с ними признаков, называются факторными, или просто факторами.

Признаки, изменяющиеся под действием факторных признаков, называются результативными.

В статистике различают функциональную и стохастическую зависимости.

Функциональной называют такую связь, при которой определенному значению факторного признака соответствует одно и только одно значение результативного признака.

Если причинная зависимость проявляется не в каждом отдельном случае, а в общем, среднем, при большом числе наблюдений, то такая зависимость называется стохастической. Частным случаем стохастической связи является корреляционная связь, при которой изменение среднего значения результативного признака обусловлено изменением факторных признаков.

Связи между явлениями и их признаками классифицируются по степени тесноты, направлению и аналитическому выражению.

Таблица 11.1. ‑ Количественные критерии оценки тесноты связи

Величина показателя связи

По направлению выделяют связь прямую и обратную.

Прямая ‑ это связь, при которой с увеличением или с уменьшением значений факторного признака происходит увеличение или уменьшение значений результативного признака.

Пример. Так, рост объемов производства способствует увеличению прибыли предприятия.

В случае обратной связи значения результативного признака изменяются под воздействием факторного, но в противоположном направлении по сравнению с изменением факторного признака, то есть обратная ‑ это связь, при которой с увеличением или с уменьшением значений одного признака происходит уменьшение или увеличение значений другого признака.

Пример. Так, снижение себестоимости единицы производимой продукции влечет за собой рост рентабельности.

По аналитическому выражению выделяют связи прямолинейные (или просто линейные) и нелинейные.

Если статистическая связь между явлениями может быть приблизительно выражена уравнением прямой линии, то ее называют линейной связью вида:

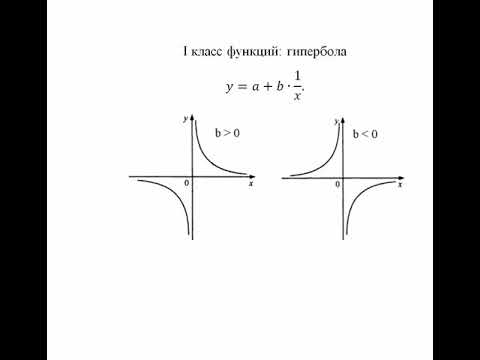

Если же связь может быть выражена уравнением какой-либо кривой, то такую связь называют нелинейной или криволинейной, например:

Для выявления наличия связи, ее характера и направления в статистике используются методы: приведения параллельных данных; графический; аналитических группировок; корреляции, регрессии.

Метод приведения параллельных данных основан на сопоставлении двух или нескольких рядов статистических величин. Такое сопоставление позволяет установить наличие связи и получить представление о ее характере.

Графически взаимосвязь двух признаков изображается с помощью поля корреляции. В системе координат на оси абсцисс откладываются значения факторного признака, а на оси ординат ‑ результативного. Каждое пересечение линий, проводимых через эти оси, обозначаются точкой. При отсутствии тесных связей имеет место беспорядочное расположение точек на графике. Чем сильнее связь между признаками, тем теснее будут группироваться точки вокруг определенной линии, выражающей форму связи.

В статистике принято различать следующие виды зависимостей:

- Парная корреляция ‑ связь между двумя признаками (результативным и факторным, или двумя факторными).

- Частная корреляция ‑ зависимость между результативным и одним факторным признаками при фиксированном значении других факторных признаков.

- Множественная корреляция ‑ зависимость результативного и двух или более факторных признаков, включенных в исследование.

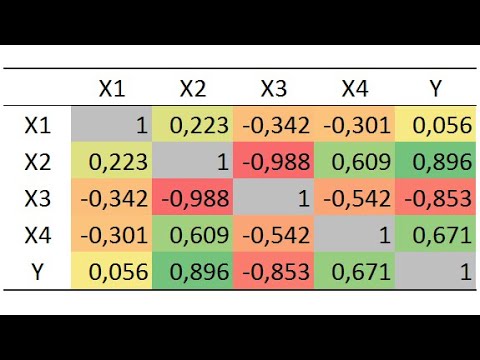

Корреляционный анализ имеет своей задачей количественное определение тесноты и направления связи между двумя признаками (при парной связи) и между результативным и множеством факторных признаков (при многофакторной связи).

Теснота связи количественно выражается величиной коэффициентов корреляции, которые, давая количественную характеристику тесноты связи между признаками, позволяют определять «полезность» факторных признаков при построении уравнения множественной регрессии. Знаки при коэффициентах корреляции характеризуют направление связи между признаками.

Регрессия тесно связана с корреляцией и позволяет исследовать аналитическое выражение взаимосвязи между признаками.

Регрессионный анализ заключается в определении аналитического выражения связи, в котором изменение одной величины (называемой зависимой или результативным признаком), обусловлено влиянием одной или нескольких независимых величин (факторных признаков).

Одной из проблем построения уравнений регрессии является их размерность, то есть определение числа факторных признаков, включаемых в модель. Их число должно быть оптимальным. Сокращение размерности за счет исключения второстепенных, несущественных факторов позволяет получить модель, быстрее и качественнее реализуемую. В то же время, построение модели малой размерности может привести к тому, что она будет недостаточно полно описывать исследуемое явление или процесс.

При построении моделей регрессии должны соблюдаться требования:

- Совокупность исследуемых исходных данных должна быть однородной и математически описываться непрерывными функциями.

- Возможность описания моделируемого явления одним или несколькими уравнениями причинно-следственных связей.

- Все факторные признаки должны иметь количественное (числовое) выражение.

- Наличие достаточно большого объема исследуемой совокупности (в последующих примерах в целях упрощения изложения материала это условие нарушено, т.е. объем очень мал).

- Причинно-следственные связи между явлениями и процессами должны описываться линейной или приводимой к линейной форме зависимостью.

- Отсутствие количественных ограничений на параметры модели связи.

- Постоянство территориальной и временной структуры изучаемой совокупности.

Соблюдение данных требований позволяет построить модель, наилучшим образом описывающую реальные социально-экономические явления и процессы.

Парная регрессия на основе метода наименьших квадратов позволяет получить аналитическое выражение связи между двумя признаками: результативным и факторным.

Определить тип уравнения можно, исследуя зависимость графически, однако существуют более общие указания, позволяющие выявить уравнение связи, не прибегая к графическому изображению. Если результативный и факторный признаки возрастают одинаково, то это свидетельствует о том, что связь между ними линейная, а при обратной связи ‑ гиперболическая. Если результативный признак увеличивается в арифметической прогрессии, а факторный значительно быстрее, то используется параболическая или степенная регрессия.

Оценка параметров уравнений регрессии ( и — в уравнении параболы второго порядка) осуществляется методом наименьших квадратов, в основе которого лежит предположение о независимости наблюдений исследуемой совокупности и нахождении параметров модели , при которых минимизируется сумма квадратов отклонений эмпирических (фактических) значений результативного признака от теоретических, полученных по выбранному уравнению регрессии:

Система нормальных уравнений для нахождения параметров линейной парной регрессии методом наименьших квадратов имеет следующий вид:

где п ‑ объем исследуемой совокупности (число единиц наблюдения).

В уравнениях регрессии параметр ао показывает усредненное влияние на результативный признак неучтенных в уравнении факторных признаков. Коэффициент регрессии а1 показывает, на сколько в среднем изменяется значение результативного признака при увеличении факторного признака на единицу собственного измерения. xi – теоретические значения результативного признака; yi – наблюдаемые значения факторного признака.

Пример. Имеются данные по 10 однотипным предприятиям о выпуске продукции (х) в тыс.ед. и о расходе условного топлива (у) в тоннах (графы 1 и 2 табл. 17).

Требуется найти уравнение зависимости расхода топлива от выпуска продукции (или уравнение регрессии у по х) и измерить тесноту зависимости между ними. Для этого представим данные в табл. 11.2 (вместе с расчетными столбцами).

Таблица 11.2 – Расчет показателей для нахождения уравнения регрессии

| № п/п | Выпуск продукции, xi,тыс.ед. | Расход топлива, yi, тонн |  | |||

| 1 | 5 | 4 | 25 | 20 | 16 | 3,9 |

| 2 | 6 | 4 | 36 | 24 | 16 | 4,4 |

| 3 | 8 | 6 | 64 | 48 | 36 | 5,5 |

| 4 | 8 | 5 | 64 | 40 | 25 | 5,5 |

| 5 | 10 | 7 | 100 | 70 | 49 | 6,6 |

| 6 | 10 | 8 | 100 | 80 | 64 | 6,6 |

| 7 | 14 | 8 | 196 | 112 | 64 | 8,8 |

| 8 | 20 | 10 | 400 | 200 | 100 | 12,1 |

| 9 | 20 | 12 | 400 | 240 | 144 | 12,1 |

| 10 | 24 | 16 | 576 | 384 | 256 | 14,3 |

| ∑ * | 125 | 80 | 1961 | 1218 | 770 | 80 |

Необходимые для решения суммы рассчитаны выше в таблице. Подставим их в уравнение и решим систему.

Получив искомое уравнение регрессии можно утверждать, что с увеличение выпуска продукции на тыс. ед., расход топлива возрастет в среднем на 0,547 тонны.

* Если параметры уравнения найдены верно, то

Измерение тесноты (силы) и направления связи является важной задачей изучения и количественного измерения взаимосвязи социально-экономических явлений. Оценка тесноты связи между признаками предполагает определение меры соответствия вариации результативного признака и одного (при изучении парных зависимостей) или нескольких (множественных зависимостей) факторных признаков.

Линейный коэффициент корреляции (К. Пирсона) характеризует тесноту и направление связи между двумя коррелируемыми признаками в случае наличия между ними линейной зависимости.

В теории разработаны и на практике применяются различные модификации формулы расчета данного коэффициента.

Для измерения тесноты зависимости между у и х применяют линейный коэффициент корреляции, который может быть рассчитан по любой из нижеприведенных формул:

Таблица 11.3 – Оценка линейного коэффициента корреляции

| Значение линейного коэффициента связи | Характеристика связи | Интерпретация связи |

| г = 0 | отсутствует | – |

| 0 Линейный коэффициент корреляции может принимать по модулю значения от 0 до 1 (знак + при прямой зависимости и знак – при обратной зависимости). Найденный коэффициент корреляции По степени тесноты связи между признаками (одним из критериев оценки служит коэффициент корреляции) различают связи: Следовательно, 0,7≤0,96≤ 1 , значит, связь в данном примере сильная (с увеличением выпуска продукции увеличивается расход топлива). Термин “корреляция” впервые применил французский палеонтолог Ж. Кювье, который вывел “закон корреляции частей и органов животных” (этот закон позволяет восстанавливать по найденным частям тела облик всего животного). В статистику указанный термин ввел в 1886 году английский биолог и статистик Френсис Гальтон (не просто связь – relation, а “как бы связь” – co-relation). Однако точную формулу для подсчёта коэффициента корреляции разработал его ученик – математик и биолог – Карл Пирсон (1857 – 1936). Корреляционным называется исследование, проводимое для подтверждения или опровержения гипотезы о статистической связи между несколькими (двумя и более) переменными. В психологии переменными могут выступать психические свойства, процессы, состояния и др. Контрольные задания. По данным статистических сборников постройте таблицу: по 10 однотипным предприятиям с данными о численности персонала, выпуске продукции, расходах; данных о прожиточном минимуме и средней заработной плате и т.п.; найдите уравнение зависимости (или уравнение регрессии) и измерьте тесноту связи между показателями. Видео:Эконометрика Линейная регрессия и корреляцияСкачать  Оценка параметров линейного регрессионного уравненияДля оценки параметров регрессионного уравнения наиболее часто используют метод наименьших квадратов (МНК), в основе которого лежит предположение о независимости наблюдений исследуемой совокупности. Сущность данного метода заключается в нахождении параметров модели (α, β), при которых минимизируется сумма квадратов отклонений эмпирических (фактических) значений результативного признака от теоретических, полученных по выбранному уравнению регрессии: В итоге получаем систему нормальных уравнений: Эту систему можно записать в виде: Решая данную систему линейных уравнений с двумя неизвестными получаем оценки наименьших квадратов: В уравнениях регрессии параметр α показывает усредненное влияние на результативный признак неучтенных факторов, а параметр β – коэффициент регрессии показывает, насколько изменяется в среднем значение результативного признака при увеличении факторного на единицу. Между линейным коэффициентом корреляции и коэффициентом регрессии существует определенная зависимость, выражаемая формулой: где – коэффициент регрессии в уравнении связи; – среднее квадратическое отклонение соответствующего статистически существенного факторного признака. Имеются следующие данные о размере страховой суммы и страховых возмещений на автотранспортные средства одной из страховых компаний. Зависимость между размером страховых возмещений и страховой суммой на автотранспорт Объем страхового возмещения (тыс.долл.), Yi Стоимость застрахованного автомобиля (тыс.долл.), X i 🎦 ВидеоЭконометрика. Линейная парная регрессияСкачать  Эконометрика. Множественная регрессия и корреляция.Скачать  Эконометрика. Оценка значимости параметров уравнения регрессии. Критерий Стьюдента.Скачать  Эконометрика. Оценка значимости уравнения регрессии. Критерий ФишераСкачать  Математика #1 | Корреляция и регрессияСкачать  Расчет коэффициента корреляции в ExcelСкачать  Множественная регрессия в ExcelСкачать  Линейная регрессияСкачать  Лекция 2.1: Линейная регрессия.Скачать  Множественная регрессия в Excel и мультиколлинеарностьСкачать  Как вычислить линейный коэффициент корреляции в MS Excel и построить уравнение регрессии?Скачать  Корреляция: коэффициенты Пирсона и Спирмена, линейная регрессияСкачать  Корреляционно-регрессионный анализ. ЭтапыСкачать  Линейная регрессия. Что спросят на собеседовании? ч.1Скачать  Построение уравнения линейной регрессии методом наименьших квадратов.Скачать  Эконометрика. Нелинейная регрессия. Степенная функция.Скачать  Линейная регрессияСкачать  Корреляционно-регрессионный анализ многомерных данных в ExcelСкачать  |

означает, что характер связи между исследуемыми признаками прямой.

означает, что характер связи между исследуемыми признаками прямой.