В этом пособии рассказывается о методе главных компонент (Principal Component Analysis, PCA) – базовом подходе, применяемом в хемометрике для решения разнообразных задач. Текст ориентирован, прежде всего, на специалистов в области анализа экспериментальных данных: химиков, физиков, биологов, и т.д. Он может служить пособием для исследователей, начинающих изучение этого вопроса. Продолжить изучение вопроса можно с помощью указанной Литературы

В пособии интенсивно используются понятия и методы матричной алгебры – вектор, матрица, и т.п. Читателям, которые плохо знакомы с этим аппаратом, рекомендуется изучить, или, хотя бы просмотреть, пособие «Матрицы и векторы».

Изложение иллюстрируется примерами, выполненными в рабочей книге Excel «People.xls» которая сопровождает этот документ . Эта книга может работать без использования Chemometrics Add-In.

Ссылки на примеры помещены в текст как объекты Excel. По форме, эти примеры имеют абстрактный, модельный характер, однако, по сути, они тесно связаны с задачами, встречающимися на практике. Предполагается, что читатель имеет базовые навыки работы в среде Excel, умеет проводить простейшие матричные вычисления с использованием функций листа, таких как MMULT , TREND . Освежить эти знания можно с помощью пособия Матричные операции в Excel.

- 1. Базовые сведения

- 1.1. Данные

- 1.2. Интуитивный подход

- 1.3. Понижение размерности

- 2. Метод главных компонент

- 2.1. Формальное описание

- 2.2. Алгоритм

- 2.3. PCA и SVD

- 2.4. Счета

- 2.5. Нагрузки

- 2.6. Данные специального вида

- 2.7. Погрешности

- 2.8. Проверка

- 2.9. «Качество» декомпозиции

- 2.10. Выбор числа главных компонент

- 2.11. Неединственность PCA

- 2.12. Подготовка данных

- 2.1 3 . Размах и отклонение

- 3. Люди и страны

- 3.1. Пример

- 3.2. Данные

- 3.3. Исследование данных

- 3.4. Подготовка данных

- 3.5. Вычисление счетов и нагрузок

- 3.6. Графики счетов

- 3.7. Графики нагрузок

- 3.8. Исследование остатков

- Заключение

- Метод главных компонент: определение, применение, пример расчета

- Цели анализа компонентов

- Выбор количества точек хранения

- Виды линейных комбинаций

- Процесс прогнозирования тестовых данных

- Спектральное разложение

- Анализ Excel в биоинформатике

- Примеры анализа данных размерностей

- Анализ главных компонент (PCA)

- Шаг первый. Стандартизация

- Шаг второй. Матрица ковариации

- Шаг третий. Вычисление собственных векторов

- Шаг четвертый. Вектор признака

- Шаг 5. Трансформирование данных по осям главных компонент

- PCA и Scikit-learn

Видео:Метод главных компонент (PCA)Скачать

1. Базовые сведения

Видео:#25. Метод главных компонент (Principal Component Analysis) | Машинное обучениеСкачать

1.1. Данные

Метод главных компонент применяется к данным, записанным в виде матрицы X – прямоугольной таблицы чисел размерностью I строк и J столбцов.

Рис. 1 Матрица данных

Традиционно строки этой матрицы называются образцами. Они нумеруются индексом i, меняющимся от 1 до I. Столбцы называются переменными, и они нумеруются индексом j= 1, …, J.

Цель PCA – извлечение из этих данных нужной информации. Что является информацией, зависит от сути решаемой задачи. Данные могут содержать нужную нам информацию, они даже могут быть избыточными. Однако, в некоторых случаях, информации в данных может не быть совсем.

Размерность данных – число образцов и переменных – имеет большое значение для успешной добычи информации. Лишних данных не бывает – лучше, когда их много, чем мало. На практике это означает, что если получен спектр какого–то образца, то не нужно выбрасывать все точки, кроме нескольких характерных длин волн, а использовать их все, или, по крайней мере, значительный кусок.

Данные всегда (или почти всегда) содержат в себе нежелательную составляющую, называемую шумом. Природа этого шума может быть различной, но, во многих случаях, шум – это та часть данных, которая не содержит искомой информации. Что считать шумом, а что – информацией, всегда решается с учетом поставленных целей и методов, используемых для ее достижения.

Шум и избыточность в данных обязательно проявляют себя через корреляционные связи между переменными. Погрешности в данных могут привести к появлению не систематических, а случайных связей между переменными. Понятие эффективного (химического) ранга и скрытых, латентных переменных, число которых равно этому рангу, является важнейшим понятием в PCA

Видео:Идея и суть метода главных компонентСкачать

1.2. Интуитивный подход

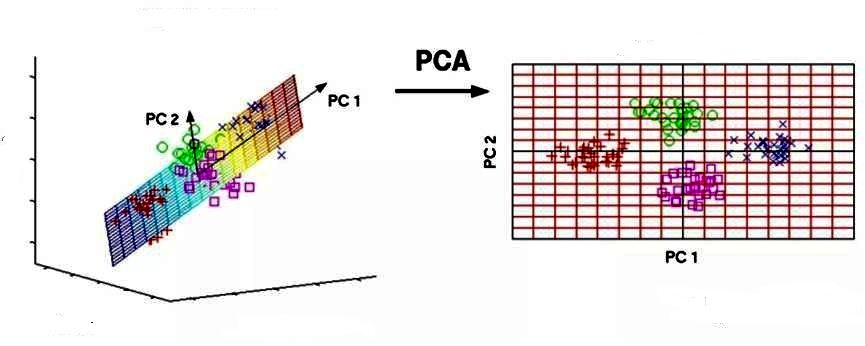

Постараемся передать суть метода главных компонент, используя интуитивно–понятную геометрическую интерпретацию. Начнем с простейшего случая, когда имеются только две переменные x1 и x2. Такие данные легко изобразить на плоскости (Рис. 2).

Рис. 2 Графическое представление двумерных данных

Каждой строке исходной таблицы (т.е. образцу) соответствует точка на плоскости с соответствующими координатами. Они обозначены пустыми кружками на Рис. 2. Проведем через них прямую, так, чтобы вдоль нее происходило максимальное изменение данных. На рисунке эта прямая выделена синим цветом; она называется первой главной компонентой – PC1. Затем спроецируем все исходные точки на эту ось. Получившиеся точки закрашены красным цветом. Теперь мы можем предположить, что на самом деле все наши экспериментальные точки и должны были лежать на этой новой оси. Просто какие–то неведомые силы отклонили их от правильного, идеального положения, а мы вернули их на место. Тогда все отклонения от новой оси можно считать шумом, т.е. ненужной нам информацией. Правда, мы должны быть в этом уверены. Проверить шум ли это, или все еще важная часть данных, можно поступив с этими остатками так же, как мы поступили с исходными данными – найти в них ось максимальных изменений. Она называется второй главной компонентой (PC2). И так надо действовать, до тех пор, пока шум уже не станет действительно шумом, т.е. случайным хаотическим набором величин.

В общем, многомерном случае, процесс выделения главных компонент происходит так:

- Ищется центр облака данных, и туда переносится новое начало координат – это нулевая главная компонента (PC0)

- Выбирается направление максимального изменения данных – это первая главная компонента (PC1)

- Если данные описаны не полностью (шум велик), то выбирается еще одно направление (PC2) – перпендикулярное к первому, так чтобы описать оставшееся изменение в данных и т.д.

Рис. 3 Графическое представление метода главных компонент

В результате, мы переходим от большого количества переменных к новому представлению, размерность которого значительно меньше. Часто удается упростить данные на порядки: от 1000 переменных перейти всего к двум. При этом ничего не выбрасывается – все переменные учитываются. В то же время несущественная для сути дела часть данных отделяется, превращается в шум. Найденные главные компоненты и дают нам искомые скрытые переменные, управляющие устройством данных.

Видео:Метод главных компонент в R (principal component analysis)Скачать

1.3. Понижение размерности

Суть метода главных компонент – это существенное понижение размерности данных. Исходная матрица X заменяется двумя новыми матрицами T и P, размерность которых, A, меньше, чем число переменных (столбцов) J у исходной матрицы X

Рис. 4 Декомпозиция матрицы X

Вторая размерность – число образцов (строк) I сохраняется. Если декомпозиция выполнена правильно – размерность A выбрана верно, то матрица T несет в себе столько же информации, сколько ее было в начале, в матрице X. При этом матрица T меньше, и, стало быть, проще, чем X.

Видео:15. МО-1 ФКН: метод главных компонентСкачать

2. Метод главных компонент

Видео:Простой пример нахождения главных компонентСкачать

2.1. Формальное описание

Пусть имеется матрица переменных X размерностью (I × J), где I – число образцов (строк), а J – это число независимых переменных (столбцов), которых, как правило, много (J>>1). В методе главных компонент используются новые, формальные переменные ta (a=1,…A), являющиеся линейной комбинацией исходных переменных xj (j=1,…J)

ta=pa1x1+… + paJxJ

С помощью этих новых переменных матрица X разлагается в произведение двух матриц T и P –

Матрица T называется матрицей счетов (scores). Ее размерность (I × A).

Матрица P называется матрицей нагрузок (loadings). Ее размерность (J × A ).

E – это матрица остатков, размерностью (I × J).

Рис. 5 Разложение по главным компонентам

Новые переменные ta называются главными компонентами (Principal Components), поэтому и сам метод называется методом главных компонент (PCA). Число столбцов – ta в матрице T, и pa в матрице P, равно A, которое называется числом главных компонент (PC). Эта величина заведомо меньше числа переменных J и числа образцов I.

Важным свойством PCA является ортогональность (независимость) главных компонент. Поэтому матрица счетов T не перестраивается при увеличении числа компонент, а к ней просто прибавляется еще один столбец – соответствующий новому направлению. Тоже происходит и с матрицей нагрузок P.

Видео:Метод главных компонент - практика на PythonСкачать

2.2. Алгоритм

Чаще всего для построения PCA счетов и нагрузок, используется рекуррентный алгоритм NIPALS, который на каждом шагу вычисляет одну компоненту. Сначала исходная матрица X преобразуется (как минимум – центрируется; см. раздел 2.12) и превращается в матрицу E0, a=0. Далее применяют следующий алгоритм.

После вычисления очередной (a-ой) компоненты, полагаем ta=t и pa=p. Для получения следующей компоненты надо вычислить остатки Ea+1 = Ea – t p t и применить к ним тот же алгоритм, заменив индекс a на a+1. Программа для реализации PCA в среде MatLab приведена в пособии MatLab. Руководство для начинающих .

В этом пособии для построения PCA используется специальная надстройка для программы Excel (Add–In) Chemometrics.xla. Она дополняет список стандартных функций Excel и позволяет проводить PCA разложение на листах рабочей книги. Подробности об этой программе можно прочитать в пособии Проекционные методы в системе Excel.

После того, как построено пространство из главных компонент, новые образцы Xnew могут быть на него спроецированы, иными словами – определены матрицы их счетов Tnew. В методе PCA это делается очень просто

Tnew.=. Xnew P

Видео:A.7.37 Метод главных компонент (PCA) | линейная алгебра + теория вероятностей = анализ данныхСкачать

2.3. PCA и SVD

Метод главных компонент тесно связан с другим разложением – по сингулярным значениям, SVD. В последнем случае исходная матрица X разлагается в произведение трех матриц

Здесь U – матрица, образованная ортонормированными собственными векторами ur матрицы XX t , соответствующим значениям λr;

V– матрица, образованная ортонормированными собственными векторами vr матрицы X t X;

S – положительно определенная диагональная матрица, элементами которой являются сингулярные значения σ 1 ≥. ≥σ R ≥0 равные квадратным корням из собственных значений λr

Связь между PCA и SVD определяется следующими простыми соотношениями

Видео:Лекция 9. Факторный анализ и метод главных компонент, продолжениеСкачать

2.4. Счета

Матрица счетов T дает нам проекции исходных образцов (J –мерных векторов x1,…,xI) на подпространство главных компонент (A-мерное). Строки t1,…,tI матрицы T – это координаты образцов в новой системе координат. Столбцы t1,…,tA матрицы T – ортогональны и представляют проекции всех образцов на одну новую координатную ось.

При исследовании данных методом PCA, особое внимание уделяется графикам счетов. Они несут в себе информацию, полезную для понимания того, как устроены данные. На графике счетов каждый образец изображается в координатах (ti, tj), чаще всего – (t1, t2), обозначаемых PC1 и PC2. Близость двух точек означает их схожесть, т.е. положительную корреляцию. Точки, расположенные под прямым углом, являются некоррелироваными, а расположенные диаметрально противоположно – имеют отрицательную корреляцию.

Рис.6 График счетов

Подробнее о том, как из графиков счетов извлекается полезная информация, будет рассказано в примере.

Для матрицы счетов имеют место следующие соотношения –

где величины λ 1 ≥. ≥λ A ≥0 – это собственные значения. Они характеризуют важность каждой компоненты

Нулевое собственное значение λ0 определяется как сумма всех собственных значений, т.е.

Для вычисления PCA- счетов в надстройке Chemometrics Add-In используется функция ScoresPCA .

Видео:МЕТОД ПОДСТАНОВКИ 😉 СИСТЕМЫ УРАВНЕНИЙ ЧАСТЬ I#математика #егэ #огэ #shorts #профильныйегэСкачать

2.5. Нагрузки

Матрица нагрузок P – это матрица перехода из исходного пространства переменных x1, …xJ (J-мерного) в пространство главных компонент (A-мерное). Каждая строка матрицы P состоит из коэффициентов, связывающих переменные t и x (1). Например, a-я строка – это проекция всех переменных x1, …xJ на a-ю ось главных компонент. Каждый столбец P – это проекция соответствующей переменной xj на новую систему координат.

Рис.7 График нагрузок

График нагрузок применяется для исследования роли переменных. На этом графике каждая переменная xj отображается точкой в координатах (pi, pj), например (p1, p2). Анализируя его аналогично графику счетов, можно понять, какие переменные связаны, а какие независимы. Совместное исследование парных графиков счетов и нагрузок, также может дать много полезной информации о данных.

В методе главных компонент нагрузки – это ортогональные нормированные вектора, т.е.

Для вычисления PCA- нагрузок в надстройке Chemometrics Add-In используется функция Loadings PCA .

Видео:009. Регрессионный анализ и метод главных компонентов - К. В. ВоронцовСкачать

2.6. Данные специального вида

Результат моделирования методом главных компонент не зависит от порядка, в котором следуют образцы и/или переменные. Иными словами строки и столбцы в исходной матрице X можно переставить, но ничего принципиально не изменится. Однако, в некоторых случаях, сохранять и отслеживать этот порядок очень полезно – это позволяет лучше понять устройство моделируемых данных.

Рис. 8 Данные ВЭЖХ–ДДМ

Рассмотрим простой пример – моделирование данных, полученных методом высокоэффективной жидкостной хроматографией с детектированием на диодной матрице (ВЭЖХ–ДДМ). Данные представляются матрицей, размерностью 30 образцов (I) на 28 переменных (J). Образцы соответствуют временам удерживания от 0 до 30 с, а переменные – длинам волн от 220 до 350 нм, на которых происходит детектирование. Данные ВЭЖХ–ДДМ представлены на Рис 8.

Эти данные хорошо моделируются методом PCA с двумя главными компонентами. Ясно, что в этом примере нам важен порядок, в котором идут образцы и переменные – он задается естественным ходом времени и спектральным диапазоном. Полученные счета и нагрузки полезно изобразить на графиках в зависимости от соответствующего параметра – счета от времени, а нагрузки от длины волны. (см. Рис 9)

Рис. 9 Графики счетов и нагрузок для данных ВЭЖХ–ДДМ

Подробнее этот пример разобран в пособии Разрешение многомерных кривых .

Видео:PCA METHOD. ПРИНЦИП ГЛАВНЫХ КОМПОНЕНТСкачать

2.7. Погрешности

PCA декомпозиция матрицы X является последовательным, итеративным процессом, который можно оборвать на любом шаге a=A. Получившаяся матрица

вообще говоря, отличается от матрицы X. Разница между ними

называется матрицей остатков.

Рассмотрим геометрическую интерпретацию остатков. Каждый исходный образец xi (строка в матрице X) можно представить как вектор в J– мерном пространстве с координатами

Рис. 10 Геометрия PCA

PCA проецирует его в вектор, лежащий в пространстве главных компонент, ti=(ti1, ti2, …tiA) размерностью A. В исходном пространстве этот же вектор ti имеет координаты

Разница между исходным вектором и его проекцией является вектором остатков

Он образует i–ю строку в матрице остатков E.

Рис.11 Вычисление остатков

Исследуя остатки можно понять, как устроены данные и хорошо ли они описываются PCA моделью.

Для вычисления PCA- остатков можно использовать приемы, описанные в пособии Расширение возможностей Chemometrics Add-In.

определяет квадрат отклонения исходного вектора xi от его проекции на пространство PC. Чем оно меньше, тем лучше приближается i–ый образец.

Эта же величина, деленная на число переменных

Среднее (для всех образцов) расстояние v0 вычисляется как

Оценка общая (для всех образцов) дисперсии вычисляется так –

Видео:Метод главных компонент(Principal component analysis) часть 1Скачать

2.8. Проверка

В случае, когда PCA модель предназначена для предсказания или для классификации, а не для простого исследования данных, такая модель нуждается в подтверждении (валидации). При проверке методом тест–валидации исходный массив данных состоит из двух независимо полученных наборов, каждый из которых является достаточно представительным. Первый набор, называемый обучающим, используется для моделирования. Второй набор, называемый проверочным, служит только для проверки модели. Построенная модель применяется к данным из проверочного набора, и полученные результаты сравниваются с проверочными значениями. Таким образом принимается решение о правильности, точности моделирования.

Рис.12 Обучающий и проверочный наборы

В некоторых случаях объем данных слишком мал для такой проверки. Тогда применяют другой метод – перекрестной проверки (кросс–валидация), о котором можно прочитать здесь.

Используется также проверка методом коррекции размахом, суть которой предлагается изучить самостоятельно.

Видео:Система уравнений. Метод алгебраического сложенияСкачать

2.9. «Качество» декомпозиции

Результатом PCA моделирования являются величины

Следующие величины характеризуют «качество» моделирования в среднем.

Полная дисперсия остатков в обучении (TRVC) и в проверке (TRVP) –

Полная дисперсия выражается в тех же единицах (точнее их квадратах), что и исходные величины X.

Объясненная дисперсия остатков в обучении (ERVC) и в проверке (ERVP)

Объясненная дисперсия – это относительная величина. При ее вычислении используется естественная нормировка – сумма квадратов всех исходных величин xij. Обычно она выражается в процентах или в долях единицы. Во всех этих формулах величины eij – это элементы матриц Ec или Et. Для характеристик, наименование которых оканчивается на C (например, TRVC), используется матрица Ec (обучение), а для тех, которые оканчиваются на P (например, TRVP), берется матрица Et (проверка).

Видео:Лекция 10. Факторный анализ и метод главных компонент. SVD разложениеСкачать

2.10. Выбор числа главных компонент

Как уже отмечалось выше, метод главных компонент – это итерационная процедура, в которой новые компоненты добавляются последовательно, одна за другой. Важно знать, когда остановить этот процесс, т.е. как определить правильное число главных компонент, A. Если это число слишком мало, то описание данных будет не полным. С другой стороны, избыточное число главных компонент приводит к переоценке, т.е. к ситуации, когда моделируется шум, а не содержательная информация.

Для выбора значения числа главных компонент обычно используется график, на котором объясненная дисперсия (ERV) изображается в зависимости от числа PC. Пример такого графика приведен на Рис. 13.

Рис. 13 Выбор числа PC

Из этого графика видно, что правильное число PC – это 3 или 4. Три компоненты объясняют 95%, а четыре 98% исходной вариации. Окончательное решение о величине A можно принять только после содержательного анализа данных.

Другим полезным инструментом является график, на котором изображаются собственные значения (4) в зависимости от числа PC. Пример показан на Рис.14.

Рис. 14 График собственных значений

Из этого рисунка опять видно, что для a=3 происходит резкое изменение формы графика – излом. Поэтому верное число PC – это три или четыре.

Видео:Mашинное Oбучение -метод опорных векторов -метод главных компонентСкачать

2.11. Неединственность PCA

Разложение по методу главных компонент

не является единственным. Вместо матриц T и P можно использовать другие матрицы

с той же матрицей ошибок E. Простейший пример – это одновременное изменение знаков у соответствующих компонент векторов ta и pa, при котором произведение

остается неизменным. Алгоритм NIPALS дает именно такой результат – с точностью до знака, поэтому его реализация в разных программах может приводить к расхождениям в направлениях главных компонент.

Более сложный случай – это одновременное вращение матриц T и P. Пусть R – это ортогональная матрица вращения размерностью A × A , т.е такая матрица, что R t =R –1 . Тогда

Заметим, что новые матрицы счетов и нагрузок сохраняют все свойства старых,

Это свойство PCA называется вращательной неопределенностью. Оно интенсивно используется при решении задач разделения кривых, в частности методом прокрустова вращения. Если отказаться от условий ортогональности главных компонент, то декомпозиция матрицы станет еще более общей. Пусть теперь R – это произвольная невырожденная матрица размерностью A × A . Тогда

Эти матрицы счетов и нагрузок уже не удовлетворяют условию ортогональности и нормирования. Зато они могут состоять только из неотрицательных элементов, а также подчиняться другим требованиям, накладываемым при решении задач разделения сигналов.

Видео:Метод главных компонент - теорияСкачать

2.12. Подготовка данных

Во многих случаях, перед применением PCA, исходные данные нужно предварительно подготовить: отцентрировать и/или отнормировать. Эти преобразования проводятся по столбцам – переменным.

Центрирование – это вычитание из каждого столбца xj среднего (по столбцу) значения

Центрирование необходимо потому, что оригинальная PCA модель (2) не содержит свободного члена.

Второе простейшее преобразование данных – это нормирование. Это преобразование выравнивает вклад разных переменных в PCA модель. При этом преобразовании каждый столбец xj делится на свое стандартное отклонение.

Комбинация центрирования и нормирования по столбцам называется автошкалированием.

Любое преобразование данных – центрирование, нормирование, и т.п. – всегда делается сначала на обучающем наборе. По этому набору вычисляются значения mj и sj, которые затем применяются и к обучающему, и к проверочному набору.

В надстройке Chemometrics Add In подготовка данных проводится автоматически. Если подготовку нужно провести вручную, то для нее можно использовать стандартные функции листа или специальную пользовательскую функцию.

В задачах, где структура исходных данных X априори предполагает однородность и гомоскедастичность, подготовка данных не только не нужна, но и вредна. Именно такой случай представляют ВЭЖХ–ДДМ данные, рассмотренные в пособии Разрешение многомерных кривых.

Видео:Лекция 8. XGBoost. Факторный анализ и метод главных компонентСкачать

2.1 3 . Размах и отклонение

При заданном числе главных компонент A, величина

называется размахом (leverage). Эта величина равна квадрату расстояния Махаланобиса от центра модели до i–го образца в пространстве счетов, поэтому размах характеризует как далеко находится каждый образец в гиперплоскости главных компонент.

Для размаха имеет место соотношение

которое выполняется тождественно – по построению PCA.

Другой важной характеристикой PCA модели является отклонение v i , которое вычисляется как сумма квадратов остатков (6) – квадрат эвклидова расстояния от плоскости главных компонент до объекта i.

Две эти величины: hi и vi определяют положение объекта (образца) относительно имеющейся PCA модели. Слишком большие значения размаха и/или отклонения свидетельствуют об особенности такого объекта, который может быть экстремальным или выпадающим образцом.

Анализ величин hi и vi составляет основу SIMCA – метода классификации с обучением.

Видео:Правила нахождения неизвестных компонентовСкачать

3. Люди и страны

3.1. Пример

Метод главных компонент иллюстрируется примером, помещенным в файл People.xls.

Этот файл включает в себя следующие листы:

Layout: схемы, объясняющая имена массивов, используемых в примере

Data: данные, используемые в примере.

MVA: PCA декомпозиция, выполненная с помощью надстройки Chemometrics.xla

PCA: копия всех результатов PCA не привязанная к надстройке Chemometrics.xla

Scores1–2: анализ младших счетов PC1–PC2

Scores3–4: анализ старших счетов PC3–PC4

3.2. Данные

Анализ базируется на данных европейского демографического исследования, опубликованных в книге К. Эсбенсена.

По причинам дидактического характера используется лишь небольшой набор из 32 человек, из которых 16 представляют Северную Европу (Скандинавия) и столько же – Южную (Средиземноморье). Для баланса выбрано одинаковое количество мужчин и женщин – по 16 человек. Люди характеризуются двенадцатью переменными, перечисленными в Табл. 1.

Табл. 1 Переменные, использованные в демографическом анализе

| Height | Рост: в сантиметрах |

| Weight | Вес: в килограммах |

| Hair | Волосы: короткие: –1, или длинные: +1 |

| Shoes | Обувь: размер по европейскому стандарту |

| Age | Возраст: в годах |

| Income | Доход: в тысячах евро в год |

| Beer | Пиво: потребление в литрах в год |

| Wine | Вино: потребление в литрах в год |

| Sex | Пол: мужской: –1, или женский: +1 |

| Strength | Сила: индекс, основанный на проверке физических способностей |

| Region | Регион: север : –1, или юг: +1 |

| IQ | Коэффициент интеллекта, измеряемый по стандартному тесту |

Заметим, что такие переменные, как Sex, Hair и Region имеют дискретный характер с двумя возможными значениями: –1 или +1, тогда как остальные девять переменных могут принимать непрерывные числовые значения.

Рис. 15 Исходные данные в примере People

3.3. Исследование данных

Прежде всего, любопытно посмотреть на графиках, как связаны между собой все эти переменные. Зависит ли рост (Height ) от веса (Weight)? Отличаются ли женщины от мужчин в потреблении вина (Wine)? Связан ли доход (Income) с возрастом (Age)? Зависит ли вес (Weight) от потребления пива (Beer)?

Рис. 16 Связи между переменными в примере People.

Женщины (F) обозначены кружками ● и ● , а мужчины (M) – квадратами ■ и ■ .

Север (N) представлен голубым ■ , а юг (S) – красным цветом ● .

Некоторые из этих зависимостей показаны на Рис.16. Для наглядности на всех графиках использованы одни и те же обозначения: женщины (F) показаны кружками, мужчины (M) – квадратами, север (N) представлен голубым, а юг (S) – красным цветом.

Связь между весом (Weight) и ростом (Height) показана на Рис.16a. Очевидна, прямая (положительная) пропорциональность. Учитывая маркировку точек, можно заметить также, что мужчины (M) в большинстве своем тяжелее и выше женщин (F).

На Рис. 16b показана другая пара переменных: вес (Weight) и пиво (Beer). Здесь, помимо очевидных фактов, что большие люди пьют больше, а женщины – меньше, чем мужчины, можно заметить еще две отдельные группы – южан и северян. Первые пьют меньше пива при том же весе.

Эти же группы заметны и на Рис.16c, где показана зависимость между потреблением вина (Wine) и пива (Beer). Из него видно, что связь между этими переменными отрицательна – чем больше потребляется пива, тем меньше вина. На юге пьют больше вина, а на севере – пива. Интересно, что в обеих группах женщины располагаются слева, но не ниже по отношению к мужчинам. Это означает, что, потребляя меньше пива, прекрасный пол не уступает в вине.

Последний график на Рис. 16d показывает, как связаны возраст (Age) и доход (Income). Легко видеть, что даже в этом сравнительно небольшом наборе данных есть переменные, как с положительной, так и с отрицательной корреляцией.

Можно ли построить графики для всех пар переменных выборки? Вряд ли. Проблема состоит в том, что для 12 переменных существует 12(12–1)/2=66 таких комбинаций.

3.4. Подготовка данных

Перед тем, как подвергнуть данные анализу методом главных компонент, их надо подготовить. Простой статистический расчет показывает, что они нуждаются в автошкалировании (См. Рис. 17)

Рис. 17 Средние значения и СКО для переменных в примере People.

Средние значения по многим переменным отличаются от нуля. Кроме того, среднеквадратичные отклонения сильно разнятся. После автошкалирования среднее значение всех переменных становится равно нулю, а отклонение – единица.

Рис. 18 Автошкалированные данные в примере People.

В принципе, данные можно было бы не преобразовывать явно, на листе, а оставить как есть. Ведь стандартные хемометрические процедуры, собранные в программе Chemometrics могут центрировать и шкалировать данные при выполнении вычислений. Однако матрица автошкалированных данных понадобится нам при вычислении остатков в разделе 3.8 .

3.5. Вычисление счетов и нагрузок

Для построения PCA декомпозиции можно воспользоваться стандартными функциями ScoresPCA и LoadingsPCA, имеющимися в надстройке Chemometrics. Мы вычислим все 12 возможных главных компонент. В качестве первого аргумента используется исходный, не преобразованный массив данных, поэтому последний аргумент в обеих функциях равен 3 – автошкалирование.

Рис. 19 Вычисление матрицы счетов

Рис. 20 Вычисление матрицы нагрузок

В этом пособии все PCA вычисления проводятся в книге People.xls на листе MVA. Для удобства читателя эти же результаты продублированы на листе PCA как числа, без ссылки на надстройку Chemometrics.xla. Остальные листы рабочей книги связаны не с данными на листе MVA, с данными на листе PCA. Поэтому файл People.xls можно использовать даже тогда, когда надстройка Chemometrics.xla не установлена на компьютере.

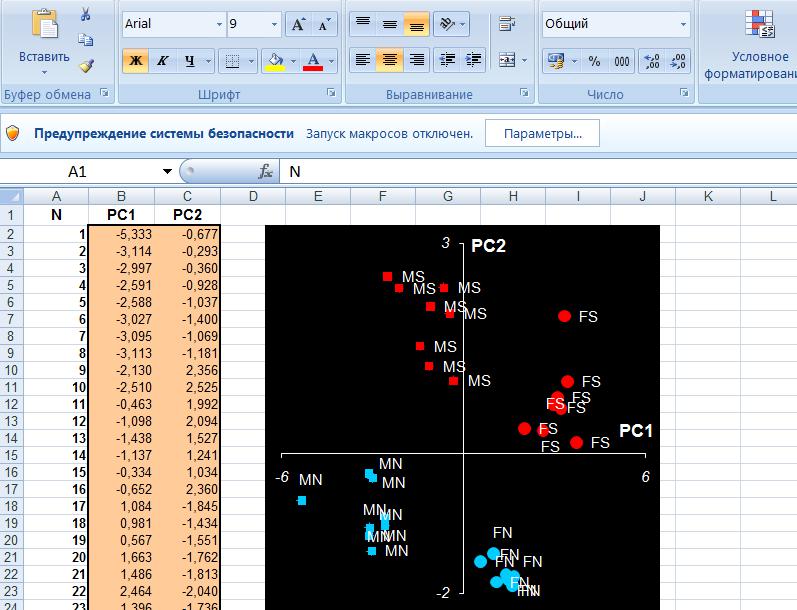

3.6. Графики счетов

Посмотрим на графики счетов, которые показывают, как расположены образцы в проекционном пространстве.

На графике младших счетов PC1–PC2 (Рис. 21) мы видим четыре отдельные группы, разложенные по четырем квадрантам: слева – женщины (F), справа – мужчины (M), сверху – юг (S), а снизу – север (N). Из этого сразу становится ясен смысл первых двух направлений PC1 и PC2. Первая компонента разделяет людей по полу, а вторая – по месту жительства. Именно эти факторы наиболее сильно влияют на разброс свойств.

Рис. 21 График счетов (PC1 – PC2) с обозначениями, использованными ранее на Рис 16

Продолжим изучение, построив график старших счетов PC3– PC4 (Рис. 22 ).

Рис. 22 График счетов (PC3 – PC4) с новыми обозначениями:

размер и цвет символов отражает доход – чем больше и светлее, тем он больше. Числа представляют возраст

Здесь уже не видно таких отчетливых групп. Тем не менее, внимательно исследовав этот график совместно с таблицей исходных данных, можно, после некоторых усилий, сделать вывод о том, что PC3 отделяет старых/богатых людей от молодых/бедных. Чтобы сделать это более очевидным, мы изменили обозначения. Теперь каждый человек показан кружком, цвет и размер которого меняется в зависимости от дохода – чем больше и светлее, тем больше доход. Рядом показан возраст каждого объекта. Как видно, возраст и доход уменьшается слева направо, т.е. вдоль PC3. А вот смысл PC4 нам по–прежнему не ясен.

3.7. Графики нагрузок

Чтобы разобраться с этим, построим соответствующие графики нагрузок. Они подскажут нам, какие переменные и как связаны между собой, что влияет на что.

Из графика младших компонент мы сразу видим, что переменные рост (Height), вес (Weight), сила (Strength) и обувь (Shoes) образуют компактную группу в правой части графика. Они практически сливаются, что означает их тесную положительную корреляцию. Переменные волосы (Hair) и пол (Sex) находятся в другой группе, лежащей по диагонали от первой группы. Это свидетельствует о высокой отрицательной корреляции между переменными из этих групп, например, силой (Strength) и полом (Sex). Наибольшие нагрузки на вторую компоненту имеют переменные вино (Wine) и регион (Region), также тесно связанные друг с другом. Переменная доход (Income) лежит на первом графике напротив переменной регион (Region), что отражает дифференциацию состоятельности: Север–Юг. Можно заметить также и антитезу переменных пиво (Beer) –регион/вино(Region/Wine).

Рис. 23 Графики нагрузок: PC1 – PC2 и PC3 – PC4

Из второго графика мы видим большие нагрузки переменных возраст (Age) и доход (Income) на ось PC3, что соответствует графику счетов на Рис. 21. Рассмотрим, переменные пиво (Beer) и IQ. Первая из них имеет большие нагрузки как на PC1, так и на PC2, фактически формируя диагональ взаимоотношений между объектами на графике счетов. Переменная IQ не обнаруживает связи с другими переменным, так как ее значения близки к нулю для нагрузок первых трех PC, и проявляет она себя только в четвертой компоненте. Мы видим, что значения IQ не зависят от места жительства, физиологических характеристик и пристрастий к напиткам.

Впервые PCA был применен еще в начале 20–го века в психологических исследованиях, когда верили, что такие показатели, как IQ или криминальное поведение можно объяснить с помощью индивидуальных физиологических и социальных характеристик. Если сравнить результаты PCA с графиками, построенными нами ранее для пар переменных, видно, что PCA сразу дает всеобъемлющее представление о структуре данных, которое можно «охватить одним взглядом» (точнее, с помощью четырех графиков). Поэтому, одна из наиболее сильных сторон PCA в исследовании структур данных – это переход от большого числа не связанных между собой графиков пар переменных к очень небольшому числу графиков счетов и нагрузок.

3.8. Исследование остатков

Сколько главных компонент нужно использовать в этом примере? Для ответа на вопрос нужно исследовать, как изменяется качество описания при увеличении числа PC. Заметим, что в этом примере мы не будем проводить проверку – в этом нет необходимости, т.к. PCA модель нужна только для исследования данных. Она не будет использоваться далее для прогнозирования, классификации, и т.п.

Рис. 24 Графики собственных значений

На Рис.24 показано, как, в зависимости от числа PC, меняются собственные значения λ . Видно, что около PC=5 происходит изменение в их поведении. Для расчета показателей TRV и ERV можно получить матрицу остатков E для каждого числа главных компонент A и вычислить требуемые показатели. Пример такого расчета для значения A=4 приведен на листе Residuals.

Рис. 25 Анализ остатков

Однако те же характеристики можно получить и проще, если воспользоваться соотношениями

Эти величины представлены на Рис. 26

Рис. 26 Графики полной (TRV) и объясненной (ERV) дисперсии остатков

Из этих зависимостей видно, что для описания данных достаточно четырех PC – они моделируют 94% данных, или, иными словами, шум, оставшийся после проекции на четырехмерное пространство PC1–PC4, оставляет всего 6% от исходных данных.

Заключение

Рассмотренный пример позволил взглянуть лишь на малую часть возможностей, предоставляемых PCA–моделированием. Мы рассмотрели задачу исследования данных, которая не предполагает дальнейшего использования построенной модели для предсказания или классификации.

Метод PCA дает основу разнообразным методам, применяемым в хемометрике. В задачах классификации – это метод SIMCA, в задачах калибровки – это метод PCR, в задачах разделения кривых – это EFA, WFA и т.д.

Метод главных компонент: определение, применение, пример расчета

Метод главных компонентов (английский — principal component analysis, PCA) упрощает сложность высокоразмерных данных, сохраняя тенденции и шаблоны. Он делает это, преобразуя данные в меньшие размеры, которые действуют, как резюме функций. Такие данные очень распространены в разных отраслях науки и техники, и возникают, когда для каждого образца измеряются несколько признаков, например, таких как экспрессия многих видов. Подобный тип данных представляет проблемы, вызванные повышенной частотой ошибок из-за множественной коррекции данных.

Метод похож на кластеризацию — находит шаблоны без ссылок и анализирует их, проверяя, взяты ли образцы из разных групп исследования, и имеют ли они существенные различия. Как и во всех статистических методах, его можно применить неправильно. Масштабирование переменных может привести к разным результатам анализа, и очень важно, чтобы оно не корректировалось, на предмет соответствия предыдущему значению данных.

Цели анализа компонентов

Основная цель метода — обнаружить и уменьшить размерность набора данных, определить новые значимые базовые переменные. Для этого предлагается использовать специальные инструменты, например, собрать многомерные данные в матрице данных TableOfReal, в которой строки связаны со случаями и столбцами переменных. Поэтому TableOfReal интерпретируется как векторы данных numberOfRows, каждый вектор которых имеет число элементов Columns.

Традиционно метод главных компонентов выполняется по ковариационной матрице или по корреляционной матрице, которые можно вычислить из матрицы данных. Ковариационная матрица содержит масштабированные суммы квадратов и кросс-произведений. Корреляционная матрица подобна ковариационной матрице, но в ней сначала переменные, то есть столбцы, были стандартизованы. Вначале придется стандартизировать данные, если дисперсии или единицы измерения переменных сильно отличаются. Чтобы выполнить анализ, выбирают матрицу данных TabelOfReal в списке объектов и даже нажимают перейти.

Это приведет к появлению нового объекта в списке объектов по методу главных компонент. Теперь можно составить график кривых собственных значений, чтобы получить представление о важности каждого. И также программа может предложить действие: получить долю дисперсии или проверить равенство числа собственных значений и получить их равенство. Поскольку компоненты получены путем решения конкретной задачи оптимизации, у них есть некоторые «встроенные» свойства, например, максимальная изменчивость. Кроме того, существует ряд других их свойств, которые могут обеспечить факторный анализ:

- дисперсию каждого, при этом доля полной дисперсии исходных переменных задается собственными значениями;

- вычисления оценки, которые иллюстрируют значение каждого компонента при наблюдении;

- получение нагрузок, которые описывают корреляцию между каждым компонентом и каждой переменной;

- корреляцию между исходными переменными, воспроизведенными с помощью р–компонента;

- воспроизведения исходных данных могут быть воспроизведены с р–компонентов;

- «поворот» компонентов, чтобы повысить их интерпретируемость.

Выбор количества точек хранения

Существует два способа выбрать необходимое количество компонентов для хранения. Оба метода основаны на отношениях между собственными значениями. Для этого рекомендуется построить график значений. Если точки на графике имеют тенденцию выравниваться и достаточно близки к нулю, то их можно игнорировать. Ограничивают количество компонентов до числа, на которое приходится определенная доля общей дисперсии. Например, если пользователя удовлетворяет 95% от общей дисперсии — получают количество компонентов (VAF) 0.95.

Основные компоненты получают проектированием многомерного статистического анализа метода главных компонентов datavectors на пространстве собственных векторов. Это можно сделать двумя способами — непосредственно из TableOfReal без предварительного формирования PCA объекта и затем можно отобразить конфигурацию или ее номера. Выбрать объект и TableOfReal вместе и «Конфигурация», таким образом, выполняется анализ в собственном окружении компонентов.

Если стартовая точка оказывается симметричной матрицей, например, ковариационной, сначала выполняют сокращение до формы, а затем алгоритм QL с неявными сдвигами. Если же наоборот и отправная точка является матрица данных, то нельзя формировать матрицу с суммами квадратов. Вместо этого, переходят от численно более стабильного способа, и образуют разложения по сингулярным значениям. Тогда матрица будет содержать собственные векторы, а квадратные диагональные элементы — собственные значения.

Виды линейных комбинаций

Основным компонентом является нормализованная линейная комбинация исходных предикторов в наборе данных по методу главных компонент для чайников. На изображении выше PC1 и PC2 являются основными компонентами. Допустим, есть ряд предикторов, как X1, X2. Xp.

Основной компонент можно записать в виде: Z1 = 11X1 + 21X2 + 31X3 + . + p1Xp

- Z1 — является первым главным компонентом;

- p1 — является вектором нагрузки, состоящим из нагрузок (1, 2.) первого основного компонента.

Нагрузки ограничены суммой квадрата равного 1. Это связано с тем, что большая величина нагрузок может привести к большой дисперсии. Он также определяет направление основной компоненты (Z1), по которой данные больше всего различаются. Это приводит к тому, что линия в пространстве р-мер, ближе всего к n-наблюдениям.

Близость измеряется с использованием среднеквадратичного евклидова расстояния. X1..Xp являются нормированными предикторами. Нормализованные предикторы имеют среднее значение, равное нулю, а стандартное отклонение равно единице. Следовательно, первый главный компонент — это линейная комбинация исходных предикторных переменных, которая фиксирует максимальную дисперсию в наборе данных. Он определяет направление наибольшей изменчивости в данных. Чем больше изменчивость, зафиксированная в первом компоненте, тем больше информация, полученная им. Ни один другой не может иметь изменчивость выше первого основного.

Первый основной компонент приводит к строке, которая ближе всего к данным и сводит к минимуму сумму квадрата расстояния между точкой данных и линией. Второй главный компонент (Z2) также представляет собой линейную комбинацию исходных предикторов, которая фиксирует оставшуюся дисперсию в наборе данных и некоррелирована Z1. Другими словами, корреляция между первым и вторым компонентами должна равняться нулю. Он может быть представлен как: Z2 = 12X1 + 22X2 + 32X3 + . + p2Xp.

Если они некоррелированы, их направления должны быть ортогональными.

Процесс прогнозирования тестовых данных

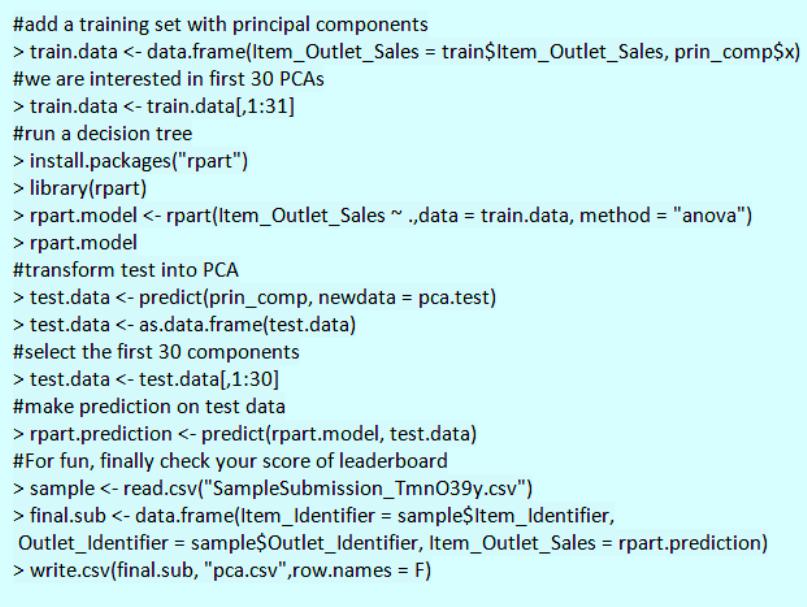

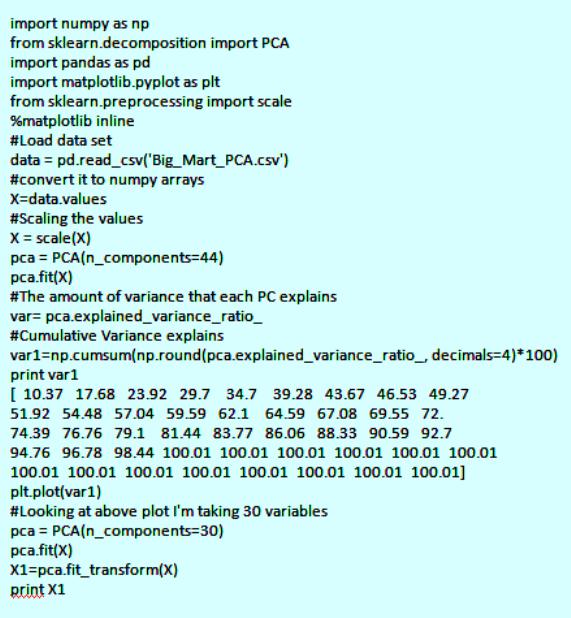

После того как вычислены главные компоненты начинают процесс прогнозирования тестовых данных с их использованием. Процесс метода главных компонент для чайников прост.

Например, необходимо сделать преобразование в тестовый набор, включая функцию центра и масштабирования в языке R (вер.3.4.2) и его библиотеке rvest. R — свободный язык программирования для статистических вычислений и графики. Он был реконструирован в 1992 году для решения статистических задач пользователями. Это полный процесс моделирования после извлечения PCA.

Набор данных Python:

Для реализации PCA в python импортируют данные из библиотеки sklearn. Интерпретация остается такой же, как и пользователей R. Только набор данных, используемый для Python, представляет собой очищенную версию, в которой отсутствуют вмененные недостающие значения, а категориальные переменные преобразуются в числовые. Процесс моделирования остается таким же, как описано выше для пользователей R. Метод главных компонент, пример расчета:

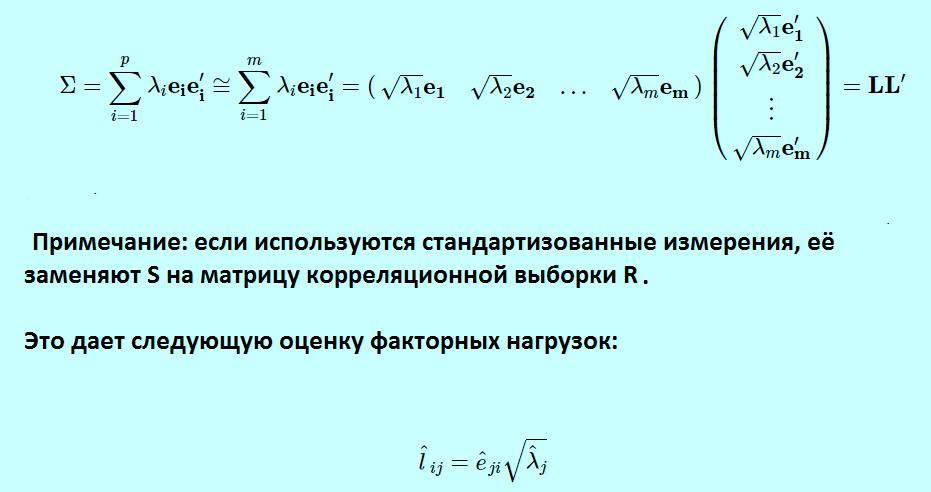

Спектральное разложение

Идея метода основного компонента заключается в приближении этого выражения для выполнения факторного анализа. Вместо суммирования от 1 до p теперь суммируются от 1 до m, игнорируя последние p-m членов в сумме и получая третье выражение. Можно переписать это, как показано в выражении, которое используется для определения матрицы факторных нагрузок L, что дает окончательное выражение в матричной нотации. Если используются стандартизованные измерения, заменяют S на матрицу корреляционной выборки R.

Это формирует матрицу L фактор-нагрузки в факторном анализе и сопровождается транспонированной L. Для оценки конкретных дисперсий фактор-модель для матрицы дисперсии-ковариации.

Теперь будет равна матрице дисперсии-ковариации минус LL ‘ .

Основные компоненты определяются по формуле

- Xi — вектор наблюдений для i-го субъекта.

- S обозначает нашу выборочную дисперсионно-ковариационную матрицу.

Тогда p собственные значения для этой матрицы ковариации дисперсии, а также соответствующих собственных векторов для этой матрицы.

Собственные значения S:λ^1, λ^2, . , λ^п.

Собственные векторы S:е^1, e^2, . , e^п.

Анализ Excel в биоинформатике

Анализ PCA — это мощный и популярный метод многомерного анализа, который позволяет исследовать многомерные наборы данных с количественными переменными. По этой методике широко используется метод главных компонент в биоинформатике, маркетинге, социологии и многих других областях. XLSTAT предоставляет полную и гибкую функцию для изучения данных непосредственно в Excel и предлагает несколько стандартных и расширенных опций, которые позволят получить глубокое представление о пользовательских данных.

Можно запустить программу на необработанных данных или на матрицах различий, добавить дополнительные переменные или наблюдения, отфильтровать переменные в соответствии с различными критериями для оптимизации чтения карт. Кроме того, можно выполнять повороты. Легко настраивать корреляционный круг, график наблюдений в качестве стандартных диаграмм Excel. Достаточно перенести данные из отчета о результатах, чтобы использовать их в анализе.

XLSTAT предлагает несколько методов обработки данных, которые будут использоваться на входных данных до вычислений основного компонента:

- Pearson, классический PCA, который автоматически стандартизирует данные для вычислений, чтобы избежать раздутого влияния переменных с большими отклонениями от результата.

- Ковариация, которая работает с нестандартными отклонениями.

- Полихорические, для порядковых данных.

Примеры анализа данных размерностей

Можно рассмотреть метод главных компонентов на примере выполнения симметричной корреляционной или ковариационной матрицы. Это означает, что матрица должна быть числовой и иметь стандартизованные данные. Допустим, есть набор данных размерностью 300 (n) × 50 (p). Где n — представляет количество наблюдений, а p — число предикторов.

Поскольку имеется большой p = 50, может быть p(p-1)/2 диаграмма рассеяния. В этом случае было бы хорошим подходом выбрать подмножество предиктора p (p 21 сентября, 2018

Анализ главных компонент (PCA)

Анализ главных компонент – это метод понижения размерности Датасета (Dataset), который преобразует больший набор переменных в меньший с минимальными потерями информативности.

Уменьшение количества переменных в наборе данных происходит в ущерб точности, но хитрость здесь заключается в том, чтобы потерять немного в точности, но обрести простоту. Поскольку меньшие наборы данных легче исследовать и визуализировать, анализ данных становится намного проще и быстрее для Алгоритмов (Algorithm) Машинного обучения (ML).

Идея PCA проста: уменьшить количество переменных в наборе данных, сохранив при этом как можно больше информации.

Шаг первый. Стандартизация

Мы осуществляем Стандартизацию (Standartization) исходных переменных, чтобы каждая из них вносила равный вклад в анализ. Почему так важно выполнить стандартизацию до PCA? Метод очень чувствителен к Дисперсиям (Variance) исходных Признаков (Feature). Если есть больши́е различия между диапазонами исходных переменных, те переменные с бо́льшими диапазонами будут преобладать над остальными (например, переменная, которая находится в диапазоне от 0 до 100, будет преобладать над переменной, которая находится в диапазоне от 0 до 1), что приведет к необъективным результатам. Преобразование данных в сопоставимые масштабы может предотвратить эту ситуацию.

Математически это можно сделать путем вычитания Среднего значения (Mean) из каждого значения и деления полученной разности на Стандартное отклонение (Standard Deviation). После стандартизации все переменные будут преобразованы в исходные значения.

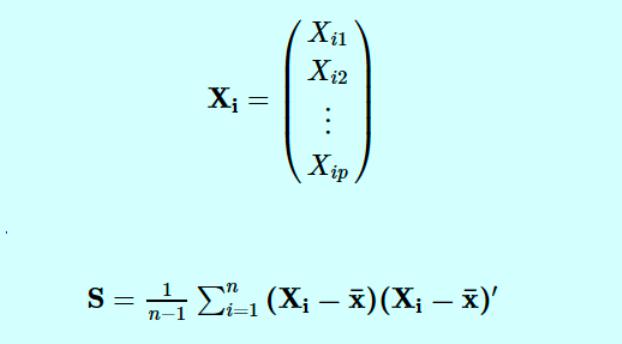

Шаг второй. Матрица ковариации

Цель этого шага – понять, как переменные отличаются от среднего по отношению друг к другу, или, другими словами, увидеть, есть ли между ними какая-либо связь. Порой переменные сильно коррелированы и содержат избыточную информацию, и чтобы идентифицировать эти взаимосвязи, мы вычисляем Ковариационную матрицу (Covariance Matrix).

Ковариационная матрица представляет собой симметричную матрицу размера p × p (где p – количество измерений), где в качестве ячеек пребывают коэффициенты ковариации, связанные со всеми возможными парами исходных переменных. Например, для трехмерного набора данных с 3 переменными x, y и z ковариационная матрица представляет собой следующее:

Поскольку ковариация переменной с самой собой – это ее дисперсия, на главной диагонали (от верхней левой ячейки к нижней правой), у нас фактически есть дисперсии каждой исходной переменной. А поскольку ковариация коммутативна (в ячейке XY значение равно YX), элементы матрицы симметричны относительно главной диагонали.

Что коэффициенты ковариации говорят нам о корреляциях между переменными? На самом деле, имеет значение знак ковариации. Если коэффициент – это:

- положительное число, то две переменные прямо пропорциональны, то есть второй увеличивается или уменьшается вместе с первым.

- отрицательное число, то переменные обратно пропорциональны, то есть второй увеличивается, когда первый уменьшается, и наоборот.

Теперь, когда мы знаем, что ковариационная матрица – это не более чем таблица, которая отображает корреляции между всеми возможными парами переменных, давайте перейдем к следующему шагу.

Шаг третий. Вычисление собственных векторов

Собственные векторы (Eigenvector) и Собственные значения (Eigenvalues) – это понятия из области Линейной алгебры (Linear Algebra), которые нам нужно экстраполировать из ковариационной матрицы, чтобы определить так называемые главные компоненты данных. Давайте сначала поймем, что мы подразумеваем под этим термином.

Главная компонента – это новая переменная, смесь исходных. Эти комбинации выполняются таким образом, что новые переменные (то есть главные компоненты) не коррелированы, и большая часть информации в исходных переменных помещается в первых компонентах. Итак, идея состоит в том, что 10-мерный датасет дает нам 10 главных компонент, но PCA пытается поместить максимум возможной информации в первый, затем максимум оставшейся информации во второй и так далее, пока не появится что-то вроде того, что показано на графике ниже:

Такая организация информации в главных компонентах позволит нам уменьшить размерность без потери большого количества информации за счет отбрасывания компонент с низкой информативностью.

Здесь важно понимать, что главные компоненты менее интерпретируемы и не имеют никакого реального значения, поскольку они построены как линейные комбинации исходных переменных.

С геометрической точки зрения, главные компоненты представляют собой Векторы (Vector) данных, которые объясняют максимальное количество отклонений. Главные компоненты – новые оси, которые обеспечивают лучший угол для оценки данных, чтобы различия между наблюдениями были лучше видны.

Поскольку существует столько главных компонент, сколько переменных в наборе, главные компоненты строятся таким образом, что первый из них учитывает наибольшую возможную дисперсию в наборе данных. Например, предположим, что диаграмма рассеяния нашего набора данных выглядит так:

Можем ли мы проецировать первый главный компонент? Да, это линия, которая соответствует фиолетовым отметкам, потому что она проходит через начало координат, и проекции точек на компонент наиболее короткие. Говоря математически, это линия, которая максимизирует дисперсию (среднее квадратов расстояний от проецируемых красных точек до начала координат).

Второй главный компонент рассчитывается таким же образом, при условии, что он не коррелирован (т.е. перпендикулярен) первому главному компоненту и учитывает следующую по величине дисперсию. Это продолжается до тех пор, пока не будет вычислено p главных компонент, равное исходному количеству переменных.

Теперь, когда мы поняли, что подразумевается под главными компонентами, давайте вернемся к собственным векторам и собственным значениям. Прежде всего, нам нужно знать, что они всегда «ходят парами», то есть каждый собственный вектор имеет собственное значение. И их количество равно количеству измерений данных. Например, для 3-мерного набора данных есть 3 переменных, следовательно, есть 3 собственных вектора с 3 соответствующими собственными значениями.

За всей магией, описанной выше, стоят собственные векторы и собственные значения, потому что собственные векторы матрицы ковариации на самом деле являются направлениями осей, где наблюдается наибольшая дисперсия (большая часть информации) и которые мы называем главными компонентами. А собственные значения – это просто коэффициенты, прикрепленные к собственным векторам, которые дают величину дисперсии, переносимую в каждом основном компоненте.

Ранжируя собственные векторы в порядке от наибольшего к наименьшему, мы получаем главные компоненты в порядке значимости.

Шаг четвертый. Вектор признака

Как мы видели на предыдущем шаге, вычисляя собственные векторы и упорядочивая их по собственным значениям в в порядке убывания, мы можем ранжировать основные компоненты в порядке значимости. На этом этапе мы выбираем, оставить ли все эти компоненты или отбросить те, которые имеют меньшее значение, и сформировать с оставшимися матрицу векторов, которую мы называем Вектором признака (Feature Vector).

Итак, вектор признаков – это просто матрица, в столбцах которой есть собственные векторы компонент, которые мы решили оставить. Это первый шаг к уменьшению размерности, потому что, если мы решим оставить только p собственных векторов (компонент) из n, окончательный набор данных будет иметь только p измерений.

Шаг 5. Трансформирование данных по осям главных компонент

На предыдущих шагах, помимо стандартизации, мы не вносили никаких изменений в данные, а просто выбирали основные компоненты и формировали вектор признаков, но исходной набор данных всегда остается.

На этом последнем этапе цель состоит в переориентации данных с исходных осей на оси, представленные главными компонентами (отсюда и название «Анализ главных компонент»). Это можно сделать, перемножив транспонированный исходный набор данных на транспонированный вектор признаков.

PCA и Scikit-learn

PCA можно реализовать с помощью SkLearn. Для начала импортируем необходимые библиотеки:

Мы будем использовать датасет банка, автоматизирующего выдачу кредитных продуктов своим клиентам:

Создадим список признаков, подлежащих уменьшению. Это макроэкономические показатели с невысоким уровнем важности, которые почти не попали в список выше. Выберем сокращаемые и Целевую переменные (Target Variable):

Выберем cамые важные признаки с помощью функции SelectKBest, которая использует критерий Хи-квадрат (Chi Square):

Создадим объект dfscores , куда отправим, соответственно, очки важности всех признаков датасета:

Создадим для коэффициентов отдельный объект, соединив названия столбцов и очки, и отобразим пять признаков, набравших наибольшее количество очков:

Неожиданно, но самыми важными признаками оказались количество сотрудников в компании и порядковый номер рекламной кампании, в которой участвует клиент:

Создадим список признаков, подлежащих понижению. Это макроэкономические показатели с невысоким уровнем важности, которые почти не попали в список выше:

Выполним стандартизацию объекта X. StandardScaler() на месте заменяет данные на их стандартизированную версию, и мы получаем признаки, где все значения как бы центрированы относительно нуля. Такое преобразование необходимо, чтобы правильно объединить признаки между собой.

Результат выглядит следующим образом:

Мы хотим получить один главный компонент. Передадим функции обучающие данные:

Мы получили вот такой главный компонент:

Ноутбук, не требующий дополнительной настройки на момент написания статьи, можно скачать здесь.